>

>

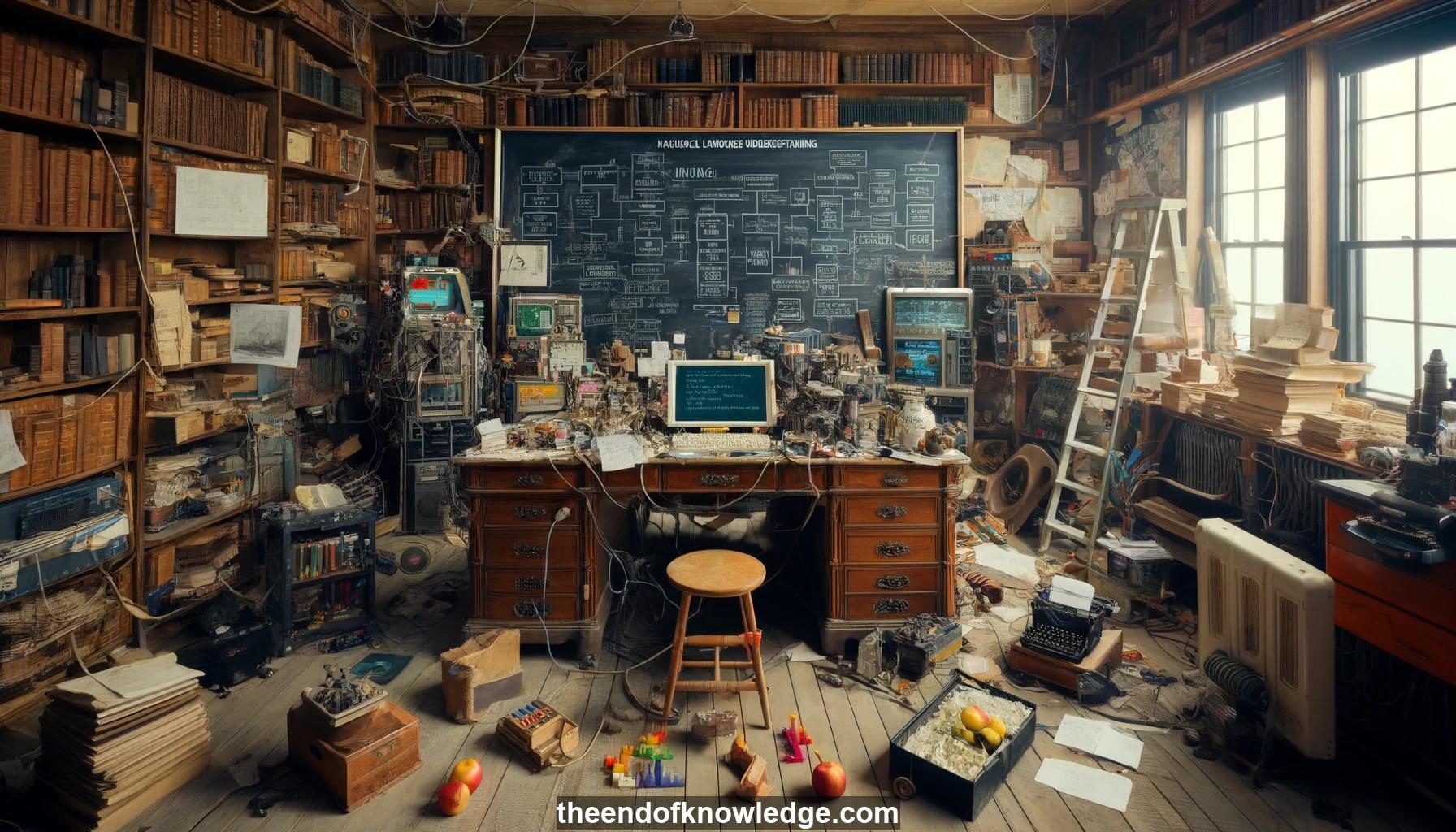

Gráfico de Conceptos & Resumen usando Claude 3.5 Sonnet | Chat GPT4o | Llama 3:

Resumen:

1.- Introducción a la comprensión del lenguaje natural (CLN): Definiendo CLN, relacionándola con la prueba de Turing y la IA/inteligencia.

2.- IBM Watson y CLN en el mundo real: Watson ganando en Jeopardy en 2011, conjunto de técnicas. CLN infiltrándose en la vida diaria.

3.- Técnicas/representaciones potenciales para CLN: Vectores de palabras/frases, árboles de dependencia, marcos, formas lógicas. Se explorarán interconexiones.

4.- PNL y aprendizaje automático - transferencia de ideas: HMMs, CRFs, LDA desarrollados para problemas de PNL. Secuencias/LSTMs impulsadas por la traducción automática.

5.- Objetivos del tutorial: Proporcionar intuiciones de CL, describir el estado del arte, comprender desafíos y oportunidades. Conceptual, no algorítmico.

6.- Sintaxis, semántica, pragmática: Niveles de análisis lingüístico. Analogías con lenguajes de programación.

7.- Sintaxis - constituyente y dependencia: Árboles de análisis de dependencia, partes del discurso, relaciones. Capturar significado requiere más que solo sintaxis.

8.- Semántica - léxica y composicional: Descubriendo significados de palabras y componiéndolos. Ambigüedad del sentido de las palabras.

9.- Semántica léxica - sinonimia: Palabras semánticamente similares. Una métrica de distancia más que clases de equivalencia. Otras relaciones como hiponimia, meronimia.

10.- Semántica composicional - teoría de modelos y composicionalidad: Las oraciones se refieren al mundo. Significado del todo compuesto de partes. Cuantificadores, modales, creencias.

11.- Pragmática - implicatura conversacional, presuposición: Lo que el hablante intenta transmitir en base al contexto. Supuestos de fondo.

12.- Desafíos del procesamiento del lenguaje - vaguedad, ambigüedad, incertidumbre: Definiciones y ejemplos de cada uno. Incertidumbre debido a la falta de conocimiento.

13.- Correferencia y anáfora: Resolviendo pronombres como "it" dependiendo del contexto. El Desafío del Esquema de Winograd.

14.- Recapitulación - sintaxis, semántica, pragmática: Definiciones, ideas clave y desafíos en cada uno.

15.- Motivación de la semántica distribucional: El contexto revela mucho sobre el significado de las palabras. Base lingüística histórica.

16.- Receta general para la semántica distribucional: Formar matriz palabra-contexto de conteos, hacer reducción de dimensionalidad. El contexto y la reducción de dimensionalidad varían.

17.- Análisis Semántico Latente (LSA): Método temprano de semántica distribucional usando documentos como contexto y SVD para reducción de dimensionalidad.

18.- Inducción de partes del discurso: Aprendizaje no supervisado de partes del discurso usando contextos de palabras circundantes y SVD.

19.- Modelo SGNS/Word2vec: Predice pares palabra-contexto usando regresión logística, optimiza PMI. Produce embeddings densos de palabras.

20.- Explorando vectores de palabras: Captura nociones de sinonimia, co-hiponimia, incluso antonimia. Implicaciones posteriores de sentimiento vs seguimiento de instrucciones.

21.- Analogías de vectores de palabras: Las diferencias de vectores capturan relaciones como género, pluralidad. Explicación a través de diferencias de contexto.

22.- Otros modelos distribucionales: HMMs, LDA, redes neuronales, redes neuronales recursivas para embeddings de frases.

23.- Patrones de Hearst: Patrones léxico-sintácticos como "X tales como Y" que revelan hiperonimia. Minado de ellos a partir de grandes corpus.

24.- Resumen de la semántica distribucional: Contexto como semántica sin pérdidas, receta general, captura información de uso matizada, útil para tareas posteriores.

25.- Consideraciones de selección de contexto: No hay aprendizaje puramente no supervisado, el contexto es parte del modelo. Global vs local, patrones, contexto no textual.

26.- Limitaciones de los modelos distribucionales actuales: Altamente parametrizados, la compresión puede no ser la vista correcta, la intención no se captura completamente.

27.- Ejemplos para reflexionar: Oraciones con significados iguales/diferentes, cómo los métodos distribucionales los manejan o fallan en ellos.

Bóveda del Conocimiento construida porDavid Vivancos 2024