>

>

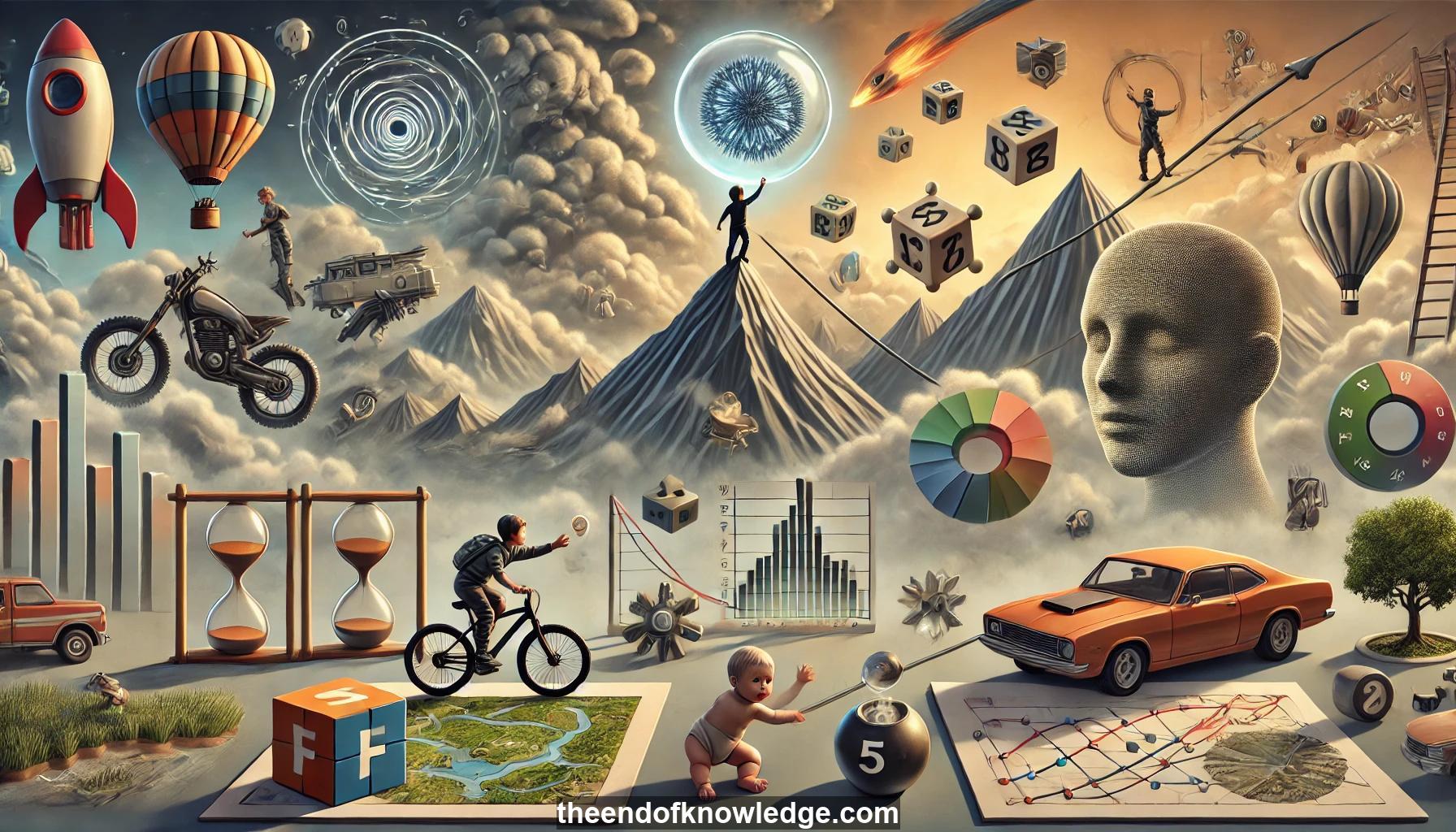

Gráfico de Conceptos & Resumen usando Claude 3.5 Sonnet | Chat GPT4o | Llama 3:

Resumen:

1.- Aprendizaje auto-supervisado: Aprender de datos no etiquetados prediciendo partes de la entrada a partir de otras partes, sin etiquetas curadas por humanos.

2.- Limitaciones del aprendizaje supervisado: Requiere grandes conjuntos de datos etiquetados, que no siempre están disponibles para todos los problemas.

3.- Ineficiencia del aprendizaje por refuerzo: Requiere muchos ensayos, impráctico para aplicaciones del mundo real como los coches autónomos.

4.- Eficiencia del aprendizaje humano: Los humanos aprenden rápidamente con pocas muestras, sugiriendo que nos falta algo en los enfoques de aprendizaje automático.

5.- Aprendizaje de modelos del mundo: La clave para mejorar la IA es aprender modelos de cómo funciona el mundo para permitir un aprendizaje eficiente.

6.- Etapas de aprendizaje de los bebés: Los bebés aprenden conceptos básicos como la permanencia del objeto y la gravedad a lo largo del tiempo a través de la interacción con el mundo.

7.- Definición de aprendizaje auto-supervisado: Entrenar grandes redes para entender el mundo a través de tareas de predicción en datos no etiquetados.

8.- Predicción bajo incertidumbre: Desafío en el aprendizaje auto-supervisado para datos continuos y de alta dimensión como imágenes o videos.

9.- Modelos de variables latentes: Usar variables adicionales para modelar la incertidumbre y generar múltiples salidas posibles.

10.- Aprendizaje basado en energía: Formular el aprendizaje auto-supervisado como el aprendizaje de funciones de energía que capturan dependencias de datos.

11.- Métodos contrastivos: Reducir la energía de los puntos de datos mientras se aumenta la energía de los puntos fuera del colector de datos.

12.- Variables latentes regularizadas: Limitar el volumen del espacio de baja energía regularizando las variables latentes.

13.- Codificación dispersa: Ejemplo temprano de sistemas de variables latentes regularizadas para aprender representaciones de datos.

14.- Descomposición dispersa predictiva: Entrenar un predictor para estimar códigos dispersos óptimos, evitando la optimización costosa.

15.- Representaciones jerárquicas: Aprender códigos dispersos de múltiples capas para datos complejos como imágenes, un área de investigación en curso.

16.- Aprendizaje por refuerzo basado en modelos: Usar modelos del mundo aprendidos para acelerar la adquisición de habilidades, especialmente en tareas motoras.

17.- Teoría del control óptimo: Enfoque clásico para el control usando modelos del mundo diferenciables, base para algunas técnicas modernas de IA.

18.- Ejemplo de conducción autónoma: Aprender a conducir en simulación usando un modelo del mundo entrenado con datos reales de conducción.

19.- Modelo de predicción de video: Red neuronal entrenada para predecir cuadros futuros en videos de conducción, manejando la incertidumbre con variables latentes.

20.- Regularizar variables latentes: Usar técnicas como el dropout para evitar que las variables latentes capturen demasiada información.

21.- Similitud con autoencoder variacional: Agregar ruido a la salida del codificador para limitar el contenido de información, similar a los VAEs.

22.- Entrenamiento de red de política: Usar el modelo del mundo aprendido para entrenar una política de conducción a través de retropropagación, sin interacción en el mundo real.

23.- Curiosidad inversa: Fomentar que el agente se mantenga en áreas donde su modelo del mundo es preciso, evitando predicciones poco fiables.

24.- Manejo de la incertidumbre en espacios continuos: Desafío técnico clave en el aprendizaje auto-supervisado para datos de alta dimensión.

25.- Limitaciones de GANs: Aunque útiles para manejar la incertidumbre, los GANs son difíciles de entrenar de manera confiable.

26.- Alternativas a GANs: Buscar métodos más confiables para aprender bajo incertidumbre en espacios de alta dimensión.

27.- Resurgimiento de RL basado en modelos: Interés renovado en el aprendizaje por refuerzo basado en modelos, a pesar de las limitaciones teóricas anteriores.

28.- Solución de clasificación: Algunos métodos auto-supervisados evitan la incertidumbre convirtiendo la predicción en tareas de clasificación.

29.- Ejemplo de rompecabezas: Tarea auto-supervisada de predecir posiciones relativas de parches de imagen, evitando la predicción a nivel de píxel.

30.- Dirección futura: Necesidad de abordar directamente el problema de aprender bajo incertidumbre en espacios continuos y de alta dimensión.

Bóveda de Conocimiento construida porDavid Vivancos 2024