>

>

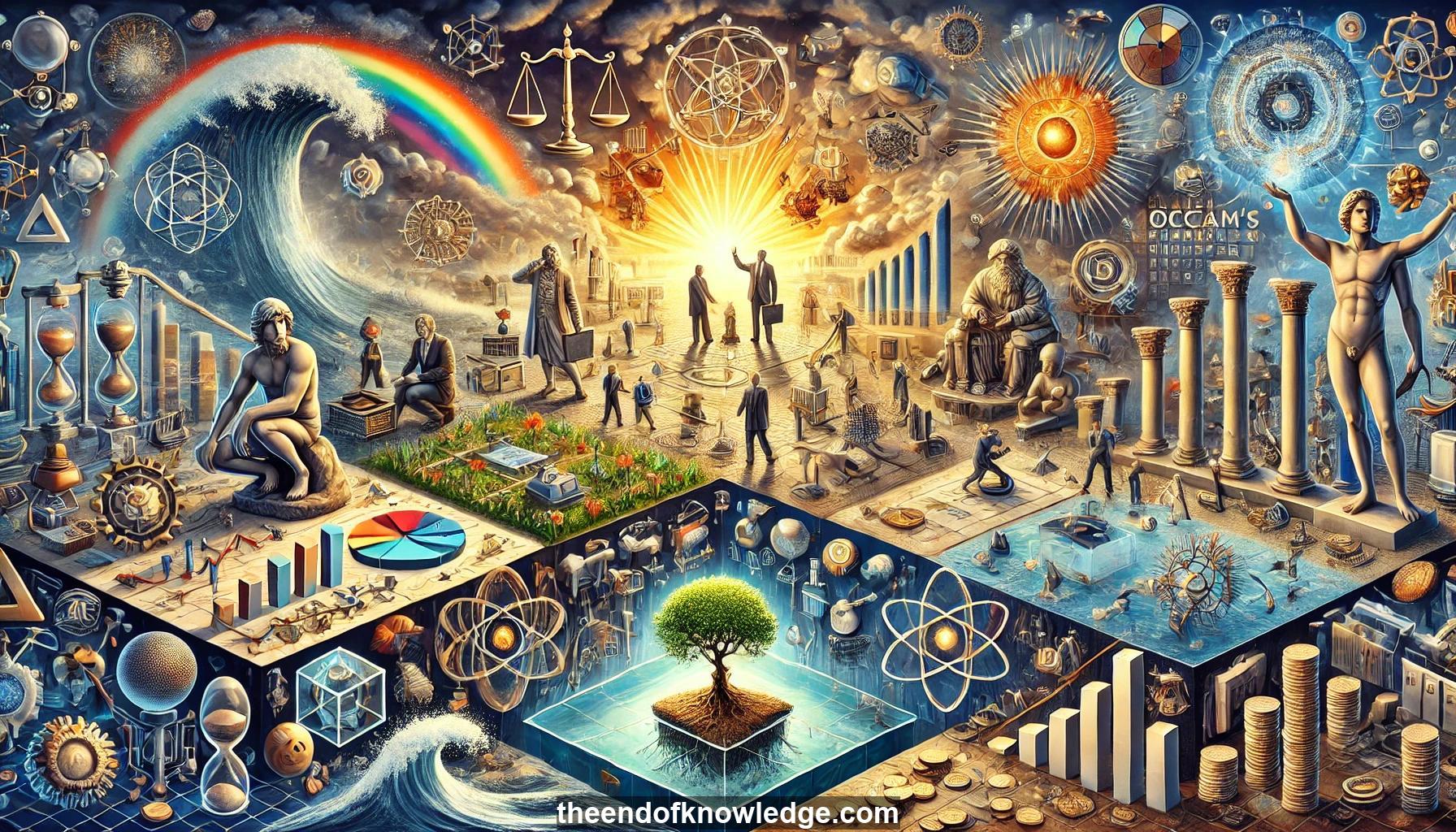

Gráfico de Conceptos & Resumen usando Claude 3.5 Sonnet | Chat GPT4o | Llama 3:

Resumen:

1.- Progreso de la IA: Los avances recientes en IA incluyen mejoras en robótica, autos autónomos, reconocimiento facial y habilidades para jugar, como AlphaZero.

2.- Definición de AGI: La Inteligencia Artificial General (AGI) es una IA que puede igualar la inteligencia humana en todas las tareas.

3.- Explosión de inteligencia: La IA que se mejora rápidamente podría llevar a la superinteligencia, superando ampliamente las capacidades humanas.

4.- Investigación en seguridad de la IA: La inversión en seguridad de la IA es crucial para garantizar sistemas robustos y confiables a medida que la IA se vuelve más prevalente en la toma de decisiones e infraestructura.

5.- Alineación de valores: Asegurar que los sistemas de IA entiendan, adopten y mantengan los objetivos humanos es esencial para prevenir consecuencias no deseadas.

6.- Subvenciones para la seguridad de la IA: El Instituto para el Futuro de la Vida otorgó subvenciones para promover la investigación y el desarrollo de IA beneficiosa.

7.- Inteligencia inteligible: Sistemas de IA que no solo son funcionales sino también comprensibles y confiables.

8.- IA inspirada en la física: Uso de conceptos de la física para mejorar el aprendizaje automático y desarrollar modelos de IA más interpretables.

9.- Teorema de aprendizaje profundo: Prueba que muestra por qué las redes neuronales profundas son más eficientes que las superficiales para ciertas tareas.

10.- Teorema de no hay almuerzo gratis: A pesar de las limitaciones, las redes neuronales pueden resolver la mayoría de los problemas relevantes para nuestro universo físico.

11.- Simplificación de la IA: Técnicas para transformar sistemas de IA complejos y de caja negra en algoritmos más simples e interpretables.

12.- Físico de IA: Investigación sobre el entrenamiento de redes neuronales para descubrir y destilar leyes de la física a partir de datos observados.

13.- Longitud de descripción mínima: Un principio para encontrar las explicaciones más simples para los datos, aplicado a la simplificación de modelos de IA.

14.- Expansión en fracciones continuas: Una técnica utilizada para simplificar y racionalizar parámetros en modelos de IA.

15.- Desigualdad de ingresos impulsada por IA: La importancia de garantizar que los beneficios económicos de la IA se compartan equitativamente en la sociedad.

16.- Armas autónomas letales: Esfuerzos para prohibir el desarrollo y uso de armas impulsadas por IA que pueden seleccionar y atacar objetivos sin intervención humana.

17.- Argumentos contra armas autónomas: Abordar objeciones comunes a la prohibición de armas autónomas letales, incluidas preocupaciones éticas y prácticas.

18.- Compromiso de empresas tecnológicas: 160 empresas y organizaciones se comprometen a no desarrollar ni apoyar armas autónomas letales.

19.- Prioridades a corto plazo de la IA: Prohibir armas autónomas letales y abordar la distribución de riqueza derivada de los avances en IA.

20.- Seguridad de la IA a largo plazo: Importancia de la investigación para asegurar resultados beneficiosos si se desarrolla AGI.

21.- Futuro optimista de la IA: Potencial para que la IA empodere a la humanidad en lugar de dominarla.

22.- Conferencias sobre seguridad de la IA: Organización de eventos para reunir a líderes y pensadores de la IA para discutir el desarrollo de IA beneficiosa.

23.- Principios de Asilomar para la IA: 23 directrices para el desarrollo de IA beneficiosa, firmadas por más de 1000 investigadores de IA.

24.- Visualización del progreso de la IA: Conceptualización del avance de la IA como niveles de agua que suben en un paisaje de tareas.

25.- Enfoque de IA híbrida: Combinación de métodos tradicionales de IA con aprendizaje automático para sistemas más interpretables y demostrables.

26.- IA en física: Uso de la IA para mejorar la investigación en física y viceversa.

27.- Descubrimiento automático de teorías: Desarrollo de sistemas de IA que puedan descubrir y formular teorías científicas de manera autónoma.

28.- Ética de la IA: Abordar preocupaciones éticas en el desarrollo de la IA, incluidas la seguridad, la equidad y la transparencia.

29.- Política de IA: El papel de los gobiernos y organizaciones en regular y guiar el desarrollo de la IA.

30.- Desarrollo proactivo de la IA: Enfatizar la importancia de anticipar y abordar desafíos potenciales de la IA antes de que surjan.

Bóveda del Conocimiento construida porDavid Vivancos 2024