>

>

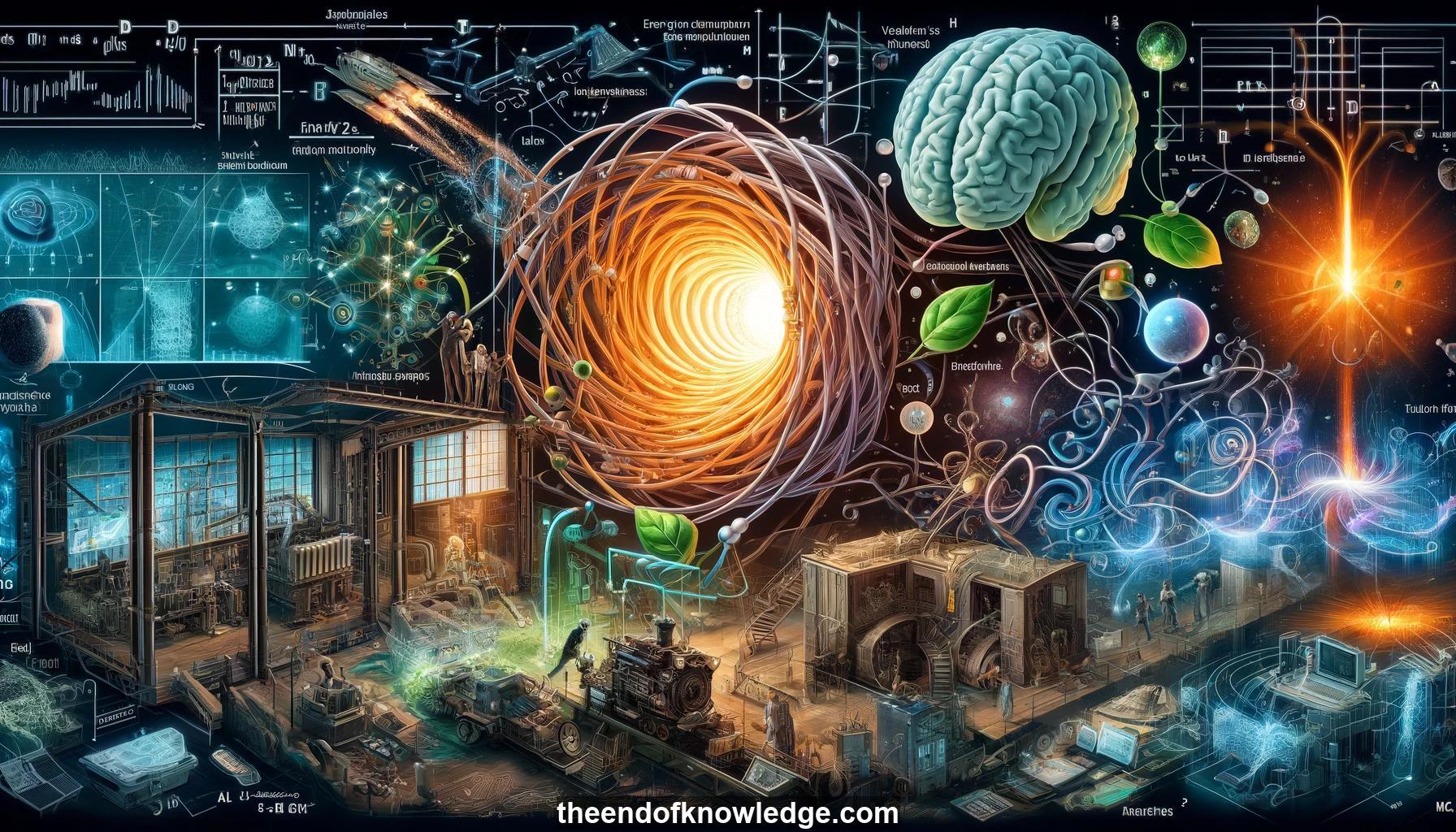

Gráfico de Conceptos & Resumen usando Claude 3.5 Sonnet | Chat GPT4o | Llama 3:

Resumen:

1.- Introducción por Jennifer Chayes de Max Welling, presidente de investigación en la Universidad de Ámsterdam, VP de Qualcomm, y roles anteriores en NIPS/ICML.

2.- Charla titulada "Inteligencia y Consumo de Energía" explorando formas de reducir el uso de energía en IA.

3.- Analogía entre la Revolución Industrial (energía/trabajo físico) y la era de la información de los años 40 (datos/eficiencia).

4.- John Wheeler afirmó que la información es fundamental para la física - "it from bit".

5.- La entropía de los agujeros negros es proporcional al área del horizonte de eventos; el principio holográfico codifica la información física en la superficie del universo.

6.- Verlinde argumenta que la gravedad es una fuerza entrópica, como una molécula estirada que se enrosca debido a fluctuaciones térmicas.

7.- Experimento mental del demonio de Maxwell sobre el uso de la información para violar la segunda ley de la termodinámica, resuelto por el principio de Landauer.

8.- Jaynes mostró que la entropía refleja la ignorancia subjetiva en el modelado, no solo una propiedad física. Conduce a la perspectiva bayesiana.

9.- Rissanen desarrolló la longitud de descripción mínima - equilibrando la complejidad del modelo y la codificación de datos. Ampliado por Hinton.

10.- Bayes variacional proporciona una ecuación explícita de energía libre para modelos con términos de energía y entropía. El truco de reparametrización permite gradientes.

11.- Objetivo: usar la entropía del modelo para ejecutar redes neuronales más eficientemente, como el cerebro. Cerrando el ciclo de energía libre.

12.- MCMC y Bayes variacional son dos enfoques para la inferencia bayesiana aproximada, equilibrando sesgo y varianza.

13.- La dinámica de Langevin de gradiente estocástico permite MCMC con minibatches para grandes conjuntos de datos. Reparametrización para Bayes variacional.

14.- El truco de reparametrización local convierte la incertidumbre de parámetros en incertidumbre de activación. Usado para compresión.

15.- Tamaño creciente de modelos de aprendizaje profundo - 100 billones de parámetros (tamaño cerebral) proyectado para 2025. Energéticamente insostenible.

16.- El valor de la IA debe exceder el costo energético para funcionar. Los dispositivos de borde tienen restricciones energéticas adicionales frente a la nube.

17.- Medir el éxito de la IA por inteligencia por kilovatiohora, no solo precisión. El cerebro es ~100x más eficiente.

18.- La compresión bayesiana elimina parámetros/activaciones inciertas. Los resultados empíricos muestran gran compresión con pérdida mínima de precisión.

19.- La distribución concreta permite aprender máscaras binarias para compresión/poda del modelo durante el entrenamiento.

20.- La compresión no necesariamente mejora la interpretabilidad. Ayuda a la regularización, estimación de confianza, privacidad, robustez adversarial.

21.- Redes neuronales de picos inspiradas por cámaras de eventos para reducir el cálculo cuando las entradas son estáticas. Logra eficiencia energética.

22.- El universo puede ser una gran computadora según Wheeler, principio holográfico. Algunos creen que vivimos en una simulación.

23.- Lydia Liu presenta un artículo sobre "Impacto Retardado del Aprendizaje Automático Justo" con coautores.

24.- Aumento de artículos sobre equidad, pero el impacto de los criterios en grupos protegidos a menudo se deja a la intuición. El artículo examina esto.

25.- Se asume que las puntuaciones (por ejemplo, crédito) correlacionan con el resultado. Los prestamistas maximizan la utilidad al establecer umbrales de puntuaciones. La equidad cambia los umbrales.

26.- Impacto retardado definido como cambio promedio de puntuación. Caracterizado como curva cóncava frente a la tasa de aceptación.

27.- Los criterios de equidad (paridad demográfica, igualdad de oportunidades) impactan a los grupos de manera diferente, a veces causando daño. Depende de las distribuciones de puntuaciones.

28.- Experimentos con datos FICO muestran que los criterios de equidad conducen a resultados muy diferentes para el grupo minoritario.

29.- Trabajo futuro: espacios de decisión más ricos más allá de lo binario, medidas de bienestar alternativas, estudiando el impacto algorítmico en sistemas sociales.

30.- Conclusión: La intervención más allá de la maximización de la utilidad es posible, pero se necesita cuidado. Considerar impactos específicos de aplicación.

Bóveda de Conocimiento construida porDavid Vivancos 2024