>

>

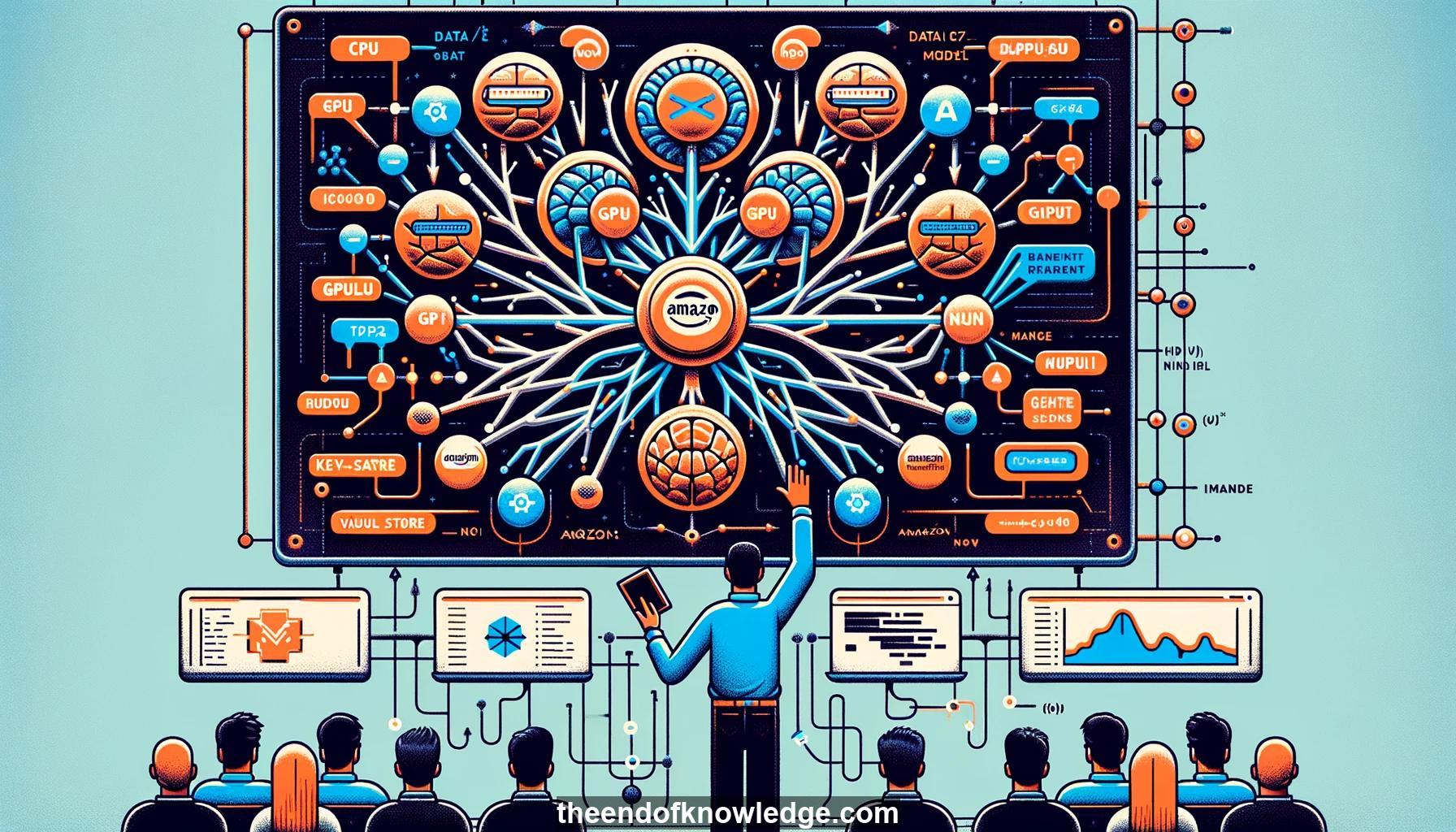

Gráfico de Conceptos & Resumen usando Claude 3.5 Sonnet | Chat GPT4o | Llama 3:

Resumen:

1.- El tutorial es sobre aprendizaje distribuido con MXNet por Alex Smolak y Arakan de Amazon.

2.- Toma una foto de la diapositiva con las instrucciones de instalación como referencia.

3.- Levanta la mano si tienes problemas durante el proceso de instalación y alguien te asistirá.

4.- Introducción a los ponentes Alex y Arakan que trabajan para Amazon, pero no en la entrega de paquetes.

5.- Comienza con MXNet en luong.mxnet.io.

6.- MXNet combina beneficios de marcos simbólicos (Caffe, Keras) y marcos imperativos (PyTorch, TensorFlow).

7.- MXNet ofrece rendimiento de marcos simbólicos y flexibilidad de marcos imperativos para aprendizaje profundo.

8.- NDArray de MXNet maneja ejecución en múltiples dispositivos en CPU, GPU y más usando evaluación perezosa sin bloqueo.

9.- El contexto de dispositivo en MXNet permite fácil movimiento de datos entre dispositivos.

10.- MXNet no permite incrementar elementos individuales en NDArrays para reforzar el paralelismo y rendimiento.

11.- El autograd de MXNet permite calcular gradientes de gráficas dinámicas y ejecutar optimización.

12.- Ejemplo de definición y entrenamiento de un modelo de regresión lineal simple en MXNet.

13.- Usando el autograd de MXNet para calcular automáticamente gradientes para optimización, incluso para gráficas dinámicas con flujo de control.

14.- Pasando a perceptrones multicapa, un tipo de red neuronal, como un ejemplo más sofisticado.

15.- Código de ejemplo definiendo una arquitectura de red neuronal multicapa usando la API de capa secuencial de MXNet.

16.- El código permite definir redes de manera flexible en un modo procedimental mientras se obtiene rendimiento de marco simbólico.

17.- Discusión de funciones de activación, funciones de pérdida y optimización basada en gradientes para entrenar redes neuronales.

18.- Generación de datos sintéticos y preparación para entrenar una red neuronal.

19.- Configuración del modelo, función de pérdida, optimizador y ajuste del modelo a los datos de entrenamiento generados.

20.- Evaluación de las predicciones del modelo entrenado y la pérdida en datos de prueba para evaluar el rendimiento.

21.- El código de MXNet permite definir modelos de manera concisa que pueden ser entrenados automáticamente mediante descenso de gradiente.

22.- Arquitecturas más complejas como redes neuronales convolucionales pueden ser definidas usando una API similar.

23.- Arquitecturas de redes neuronales predefinidas también están disponibles en el zoológico de modelos de MXNet para tareas comunes.

24.- MXNet puede utilizar múltiples GPUs y máquinas para entrenamiento distribuido de modelos grandes.

25.- Comparaciones de rendimiento mostrando la velocidad de MXNet en relación con otros marcos populares de aprendizaje profundo.

26.- El almacén de clave-valor distribuido permite fácil sincronización de parámetros para entrenamiento distribuido.

27.- Discusión de estrategias para entrenamiento eficiente multi-GPU, como paralelismo de datos y modelos.

28.- La última versión de MXNet incluye nuevas optimizaciones para entrenamiento distribuido rápido en grandes clústeres.

29.- Características adicionales en MXNet incluyen soporte para datos dispersos, formato HDF5 y operaciones matemáticas optimizadas.

30.- Indicaciones a tutoriales, ejemplos y recursos de MXNet para aprender más y comenzar rápidamente.

Vault de Conocimiento construido porDavid Vivancos 2024