>

>

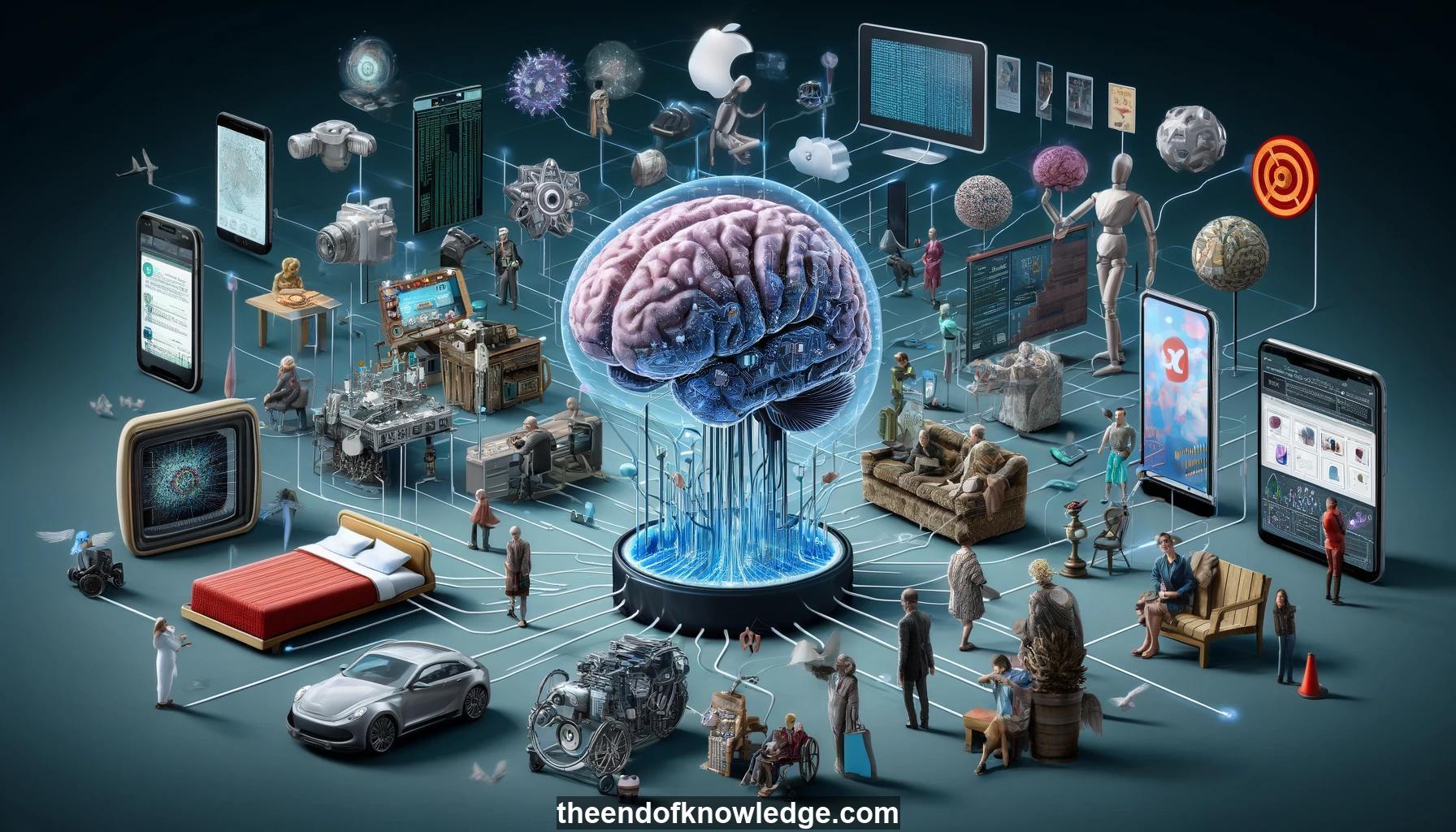

Gráfico de Conceptos & Resumen usando Claude 3.5 Sonnet | Chat GPT4o | Llama 3:

Resumen:

1.- Latanya Sweeney discute cómo los diseñadores de IA moldean la sociedad a través de decisiones de diseño tecnológico, a menudo accidentalmente y sin supervisión.

2.- Las primeras leyes de fotografía y grabación telefónica en EE.UU. fueron moldeadas por decisiones de diseño tecnológico como la falta de un botón de silencio.

3.- Los sensores de cama Sleep Number recopilan datos íntimos sin control del usuario, mientras que el Apple Watch almacena datos localmente, reflejando diferentes valores de diseño.

4.- Los diseñadores son los nuevos legisladores en una tecnocracia, incluso si no son electos, ya que sus soluciones están impulsadas por el mercado sin mucha supervisión.

5.- El trabajo temprano de Sweeney mostró cómo los datos de salud supuestamente anonimizados podrían identificar individuos al vincularlos con información públicamente disponible.

6.- A finales de los años 90, la IA se centraba más en calcular ideales matemáticos que en imitar el comportamiento humano. Las aplicaciones modernas de IA eran anteriormente investigación.

7.- Sweeney encontró que su nombre generaba anuncios en línea que implicaban que tenía antecedentes penales, lo cual ocurría más para nombres "de sonido negro" vs "de sonido blanco".

8.- Esta disparidad en la entrega de anuncios podría violar las leyes antidiscriminatorias de EE.UU. si condujera a un trato desigual, por ejemplo, en decisiones de empleo.

9.- Un sesgo similar en la entrega de anuncios apareció en sitios web dirigidos a audiencias negras, lo que podría violar las regulaciones de equidad en informes crediticios.

10.- Los datos de salud en EE.UU. fluyen de maneras complejas, con solo la mitad de las rutas cubiertas por las reglas de privacidad médica de HIPAA.

11.- El estado de Washington vendió datos hospitalarios de manera barata que podrían ser reidentificados, hasta que la investigación de Sweeney provocó un cambio de ley.

12.- La tecnología está cambiando valores e instituciones sociales fundamentales de maneras a menudo accidentales, ya que los diseñadores se centran en productos sobre impactos más amplios.

13.- Los experimentos de Sweeney que demuestran estos problemas han ayudado a fortalecer a defensores, reguladores y periodistas en la comprensión y abordaje de cambios tecnológicos.

14.- Comenzó una clase en Harvard donde los estudiantes realizaron experimentos impactantes que revelaron consecuencias tecnológicas imprevistas y presentaron hallazgos a legisladores de D.C.

15.- Ejemplos de proyectos estudiantiles incluyeron algoritmos para detectar proactivamente fraudes en línea, discriminación de precios por demografía de código postal y problemas de privacidad.

16.- El estudiante Aron expuso cómo Facebook filtró ubicaciones de usuarios, lo que provocó un cambio rápido, pero también enfrentó represalias personales de Facebook.

17.- Los diseñadores pueden minimizar daños imprevistos al considerar proactivamente cómo podrían salir mal las cosas y buscar perspectivas externas desde el principio.

18.- Los gerentes de producto que conectan equipos de diseño y preocupaciones organizacionales más amplias están bien posicionados para impulsar la consideración proactiva de posibles desventajas.

19.- Los académicos tienden a posponer estas consideraciones para la comercialización, pero incorporarlas en la investigación fundamental conduciría a mejores resultados.

20.- La discriminación es legalmente compleja: ofrecer un descuento estudiantil está permitido, cobrar sistemáticamente más por raza no lo está.

21.- Los modelos de lenguaje pueden reflejar sesgos sociales en los datos de entrenamiento: los diseñadores deben elegir si intentar cambiar o afianzar normas.

22.- Algunos temen que publicar vulnerabilidades tecnológicas permita abusos, pero Sweeney encontró que iluminar a menudo impulsa soluciones responsables que no ocurrirían de otra manera.

23.- Los conjuntos de datos utilizados para el aprendizaje automático pueden tener sesgos inherentes desconocidos que se perpetúan: se necesita una auditoría externa continua.

24.- Aunque el co-diseño con usuarios es valioso, la responsabilidad principal recae en los tecnólogos mismos para "incorporar" proactivamente consideraciones sociales.

25.- El reconocimiento facial enfrentó grandes turbulencias en 2001 entre la reacción negativa a la vigilancia del Super Bowl y el aumento de la aceptación tras el 11/9: la trayectoria puede cambiar rápidamente.

26.- Los talleres de Carnegie Mellon sobre la incorporación de protecciones de privacidad tuvieron un éxito limitado: la responsabilidad recae en los diseñadores principales.

27.- Un documento próximo muestra vulnerabilidades en 36 sitios web estatales de elecciones durante las elecciones presidenciales de 2016.

28.- El mensaje principal es que, aunque no todo se puede anticipar, los daños encontrados a través de auditorías externas deben ser abordados con soluciones constructivas.

29.- Los diseñadores de tecnología de IA tienen un inmenso poder en una tecnocracia global para moldear reglas y valores sociales de manera duradera.

30.- Los pasos proactivos de los diseñadores de IA para imaginar y experimentar con posibles daños son cruciales para ejercer esta influencia de manera responsable para el bien.

Bóveda del Conocimiento construida porDavid Vivancos 2024