>

>

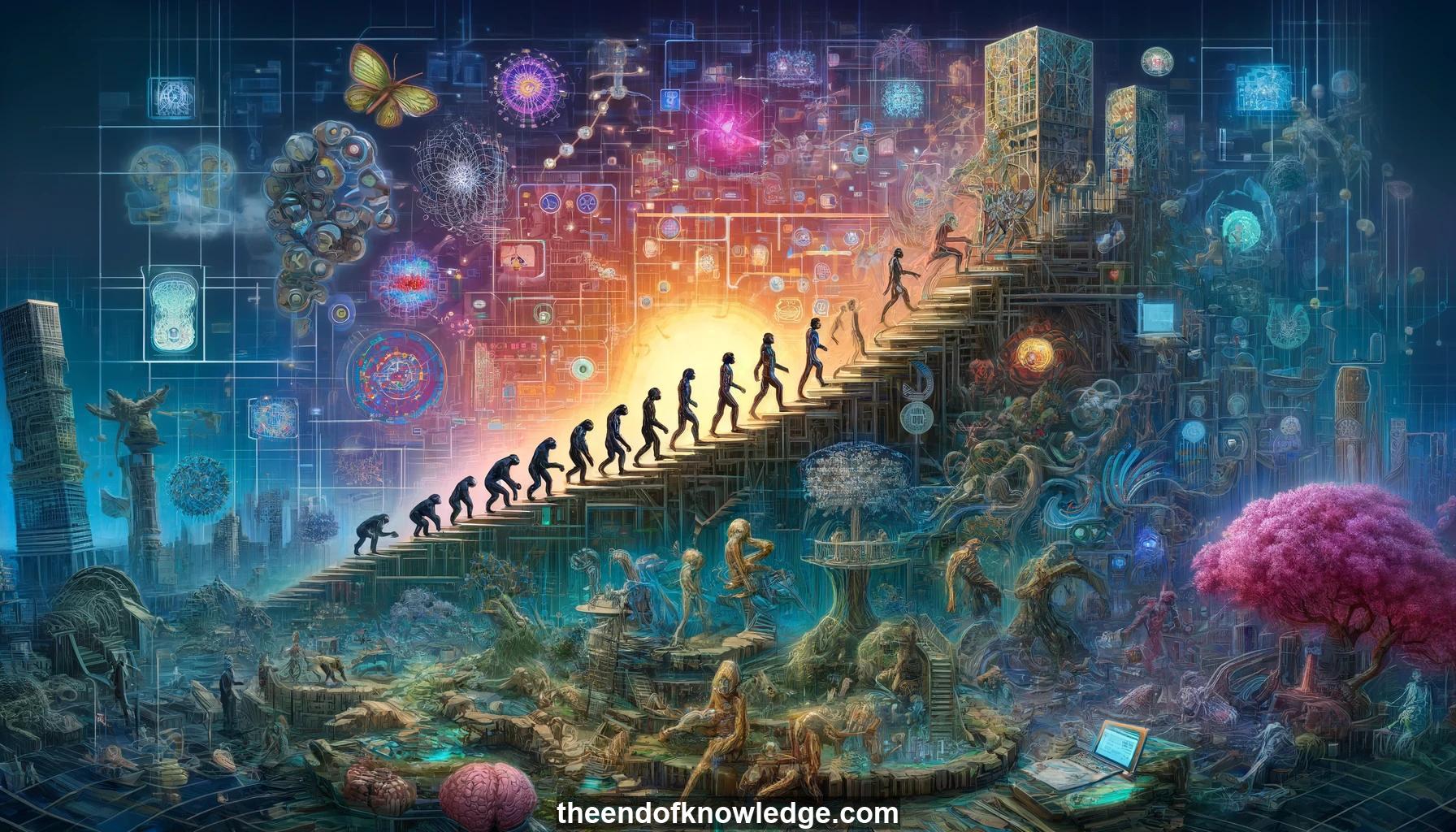

Gráfico de Conceptos & Resumen usando Claude 3.5 Sonnet | Chat GPT4o | Llama 3:

Resumen:

1.- Criaturas inteligentes evolucionaron a través de complejidad creciente en organismos y sus entornos.

2.- La inteligencia artificial requiere tanto algoritmos complejos para potencia como simples para generalidad.

3.- Los entornos para el entrenamiento de IA deben tener rica variabilidad, fundamentación en la física y complejidad de tareas para provocar comportamientos diversos.

4.- Los juegos humanos a menudo se reutilizan como entornos de entrenamiento de IA debido a sus desafíos, diversidad y funciones de recompensa incorporadas.

5.- La Venganza de Montezuma es un desafiante juego de Atari para IA debido a recompensas escasas y retrasadas y la necesidad de conceptos similares a los humanos.

6.- El aprendizaje por refuerzo feudal utiliza una jerarquía de políticas con políticas cada vez más abstractas en niveles superiores y más resolución temporal en niveles inferiores.

7.- Las Redes Feudales para RL Profundo adaptan principios de aprendizaje feudal usando redes neuronales con un gerente estableciendo metas y un trabajador alcanzándolas.

8.- La Consolidación de Peso Elástico permite a las redes neuronales aprender nuevas tareas mientras retienen el rendimiento en tareas anteriores al restringir pesos importantes.

9.- Las Redes Neuronales Progresivas evitan el olvido catastrófico agregando columnas para nuevas tareas con conexiones laterales a columnas congeladas anteriores.

10.- DISTRAL entrena políticas específicas de tareas manteniéndolas cerca de una política compartida, permitiendo la transferencia mientras se evita la divergencia o el colapso.

11.- Tareas auxiliares como la predicción de profundidad y la clasificación de cierre de bucles proporcionan gradientes estables que estructuran y aceleran el aprendizaje por refuerzo.

12.- Los agentes UNREAL aprenden tanto una política estándar como una que predice cambios de píxeles, con la repetición de experiencias mejorando la eficiencia de datos.

13.- Las tareas de navegación en laberintos 3D prueban la capacidad de la IA para explorar, memorizar y localizar objetivos usando solo entradas visuales.

14.- Los agentes de navegación se benefician de la memoria, tareas auxiliares como la predicción de profundidad y arquitecturas estructuradas que separan el aprendizaje de representación y la locomoción.

15.- StreetLearn convierte Google Street View de la ciudad de Nueva York en un entorno de RL interactivo para entrenar la navegación a gran escala.

16.- El agente de navegación StreetLearn tiene vías especializadas para el procesamiento visual, la representación de objetivos y la locomoción, permitiendo tanto la navegación específica de tareas como la general.

17.- El agente de navegación StreetLearn puede localizarse y navegar a objetivos en NYC usando solo imágenes RGB de 84x84 píxeles.

18.- Las tareas de control continuo en diversos entornos de parkour prueban las capacidades físicas de los agentes simulados.

19.- Separar las entradas propioceptivas y exteroceptivas facilita el aprendizaje de habilidades de locomoción robustas y transferibles en agentes simulados.

20.- Los currículos que progresan de terrenos más fáciles a más difíciles durante un episodio conducen a un mejor aprendizaje y transferencia general.

21.- Los agentes humanoides desarrollan estrategias de locomoción idiosincráticas pero efectivas y robustas cuando se entrenan con recompensas simples como el progreso hacia adelante.

22.- Los entornos simulados complejos proporcionan una plataforma para desarrollar sistemas de IA con potencial para aplicaciones del mundo real.

23.- Los clústeres de GPU a gran escala permiten experimentos con algoritmos de RL computacionalmente intensivos usando entradas visuales RGB.

24.- Las representaciones simplificadas y el aprendizaje por transferencia pueden hacer que los dominios de RL desafiantes sean más accesibles para la investigación con recursos computacionales limitados.

25.- La eficiencia de muestra sigue siendo un desafío significativo para aplicar RL profundo a dominios como el diálogo y la robótica donde los datos son costosos.

26.- El RL jerárquico con múltiples niveles de abstracción temporal es un enfoque prometedor para idear subobjetivos útiles y alcanzables.

27.- Los logros actuales de IA son pasos hacia AGI, pero el debate persiste sobre la definición y los desafíos restantes.

28.- El cómputo adaptativo, la memoria y la atención dentro de las redes neuronales son ingredientes clave que avanzan hacia sistemas de IA más capaces y generales.

29.- Generalizar de la simulación al mundo real es una frontera importante para los sistemas de IA que buscan abordar aplicaciones prácticas.

30.- La investigación en curso busca hacer que los sistemas de IA sean más eficientes en muestras, flexibles y robustos en entornos complejos a través de innovaciones arquitectónicas y algorítmicas.

Bóveda del Conocimiento construida porDavid Vivancos 2024