>

>

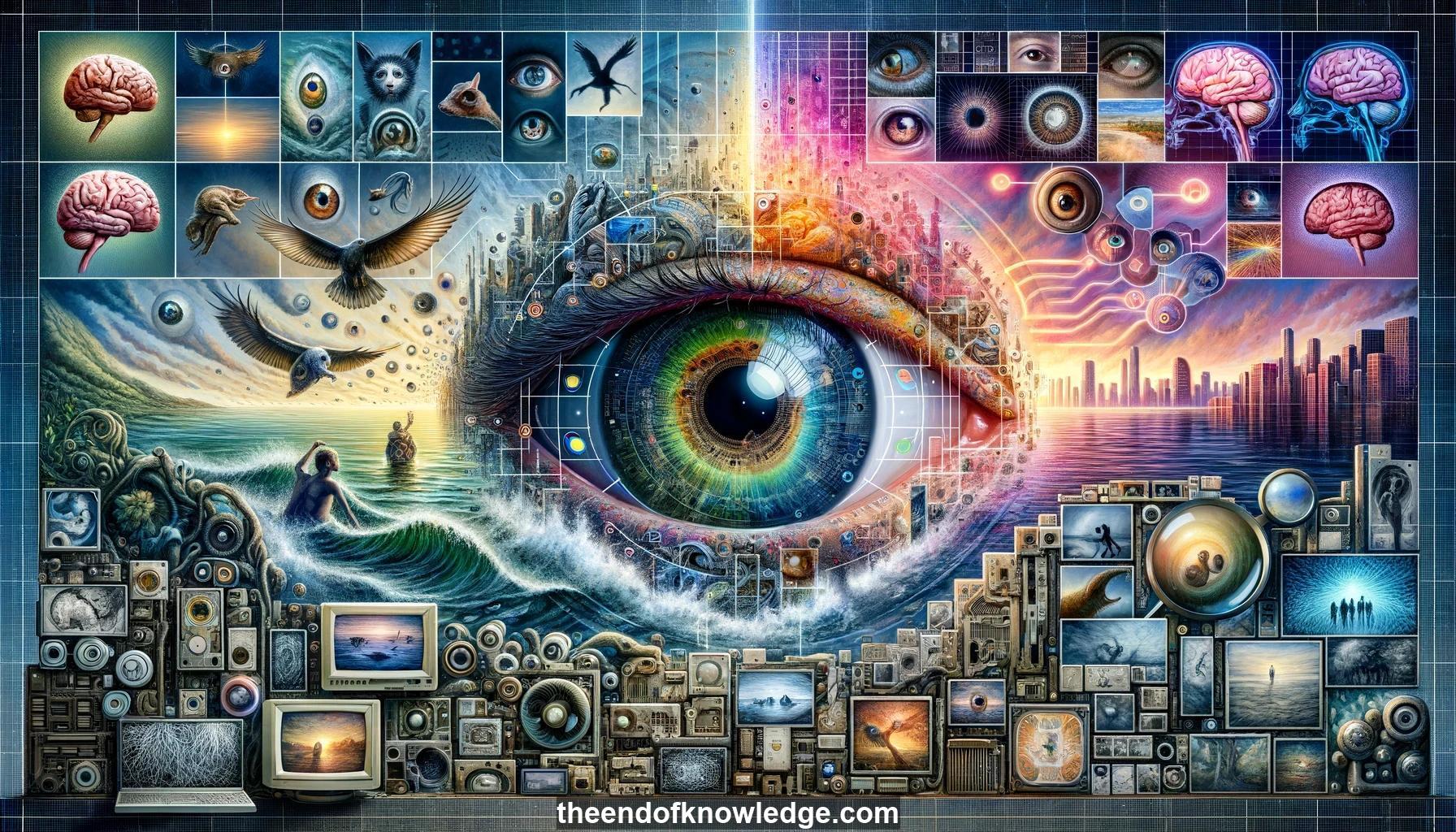

Gráfico de Conceptos & Resumen usando Claude 3.5 Sonnet | Chat GPT4o | Llama 3:

Resumen:

1.- Fei-Fei Li es profesora asociada en Stanford y directora del Laboratorio de IA, el Laboratorio de Visión por Computadora y la Investigación de IA Centrada en el Humano de Toyota.

2.- Hace 540 millones de años, la aparición de ojos en animales desencadenó una explosión en la especiación animal, iniciando una carrera armamentista evolutiva.

3.- El sistema visual humano, desarrollado a lo largo de 540 millones de años de evolución, es la maquinaria visual más poderosa del universo conocido.

4.- Los experimentos muestran que los humanos pueden entender la esencia de una escena presentada muy brevemente, escribiendo descripciones detalladas de destellos de imágenes de 500ms.

5.- La comprensión total de escenas - ser capaz de ver y entender una escena visual completa como lo hacen los humanos - es un objetivo clave para la visión por computadora.

6.- El trabajo temprano en visión por computadora en las décadas de 1960-80 se centró en crear modelos a mano para explicar el mundo 3D a partir de imágenes 2D.

7.- La visión es difícil porque medir píxeles no es lo mismo que entender escenas; el cerebro interpreta escenas usando contexto y conocimiento previo.

8.- Después de 30 años de modelado, la comunidad de visión por computadora se dio cuenta de que aprender de grandes datos era el camino hacia la inteligencia visual.

9.- Alrededor del año 2000, la visión por computadora encontró el aprendizaje automático, obteniendo herramientas como SVMs, modelos gráficos y redes neuronales para hacer un progreso real.

10.- Los algoritmos de aprendizaje de un solo intento tenían como objetivo aprender a reconocer objetos a partir de muy pocos ejemplos de entrenamiento, inspirados en el aprendizaje humano.

11.- Sin embargo, el sistema visual humano realmente requiere un entrenamiento extenso - los ojos de los infantes recolectan cientos de millones de "imágenes de entrenamiento" en sus primeros años.

12.- A principios de la década de 2000 se produjo una explosión de datos visuales en Internet, con más del 85% de los datos del ciberespacio siendo basados en píxeles para 2016.

13.- El proyecto ImageNet, iniciado en 2009, recolectó un conjunto de datos masivo de 15 millones de imágenes etiquetadas en 22,000 categorías.

14.- Usando ImageNet, se desarrollaron algoritmos para reconocer objetos mientras evitaban errores retrocediendo a categorías más generales cuando no estaban seguros.

15.- La competición de ImageNet de 2012 vio un avance en la precisión del reconocimiento de objetos con redes neuronales profundas convolucionales, marcando el renacimiento del aprendizaje profundo.

16.- El progreso en el desafío de detección de objetos de ImageNet ha sido más lento, con objetos pequeños y sin textura resultando muy difíciles de detectar para los algoritmos.

17.- Los humanos sobresalen en el uso del contexto y una visión holística de una imagen para el reconocimiento, notando diferencias significativas mientras ignoran las irrelevantes.

18.- Los primeros esfuerzos en generar descripciones de imágenes fueron limitados, usando pequeños conjuntos de datos y categorías de objetos conocidas y estructuras de oraciones.

19.- Trabajos posteriores buscaron emparejar imágenes con oraciones clasificándolas, aprendiendo características que codificaban la similitud semántica entre ambas.

20.- Para generar descripciones directamente, se usaron redes neuronales recurrentes como modelos de lenguaje, combinadas con redes neuronales convolucionales que representaban la imagen.

21.- Estos modelos de subtitulación de imágenes podían generar descripciones novedosas de imágenes, aunque aún cometían algunos errores debido a la falta de contexto.

22.- Se introdujo el conjunto de datos Visual Genome, con anotaciones más ricas que incluían entidades, atributos, relaciones, mapeadas a bases de conocimiento - interconectando imágenes.

23.- Usando Visual Genome, se desarrolló un modelo de subtitulación densa para proporcionar descripciones detalladas y contextuales de muchas regiones dentro de una imagen.

24.- El modelo de subtitulación densa también permitió la detección de objetos pequeños proporcionando contexto, resolviendo una limitación de métodos anteriores de detección de objetos.

25.- La comprensión profunda de imágenes requiere ir más allá de etiquetar objetos para también considerar relaciones, conocimiento y estructura.

26.- El viaje de la visión por computadora ha progresado desde el modelado temprano hasta los grandes datos, el aprendizaje automático, descripciones ricas y preguntas y respuestas.

27.- Sin embargo, la visión sigue siendo un problema no resuelto - mientras que los algoritmos pueden detectar objetos y describir escenas, carecen de comprensión de historias a nivel humano.

28.- Los algoritmos de hoy no pueden igualar la profundidad de la comprensión visual humana que capta sin esfuerzo historias, emociones, humor, intenciones de las imágenes.

29.- Aunque la visión por computadora ha hecho avances notables, queda mucho trabajo por hacer para acercarse a una inteligencia visual similar a la humana.

30.- Este progreso es gracias al trabajo de muchos estudiantes y colaboradores que contribuyen a avanzar el estado del arte en la comprensión visual.

Bóveda del Conocimiento construida porDavid Vivancos 2024