>

>

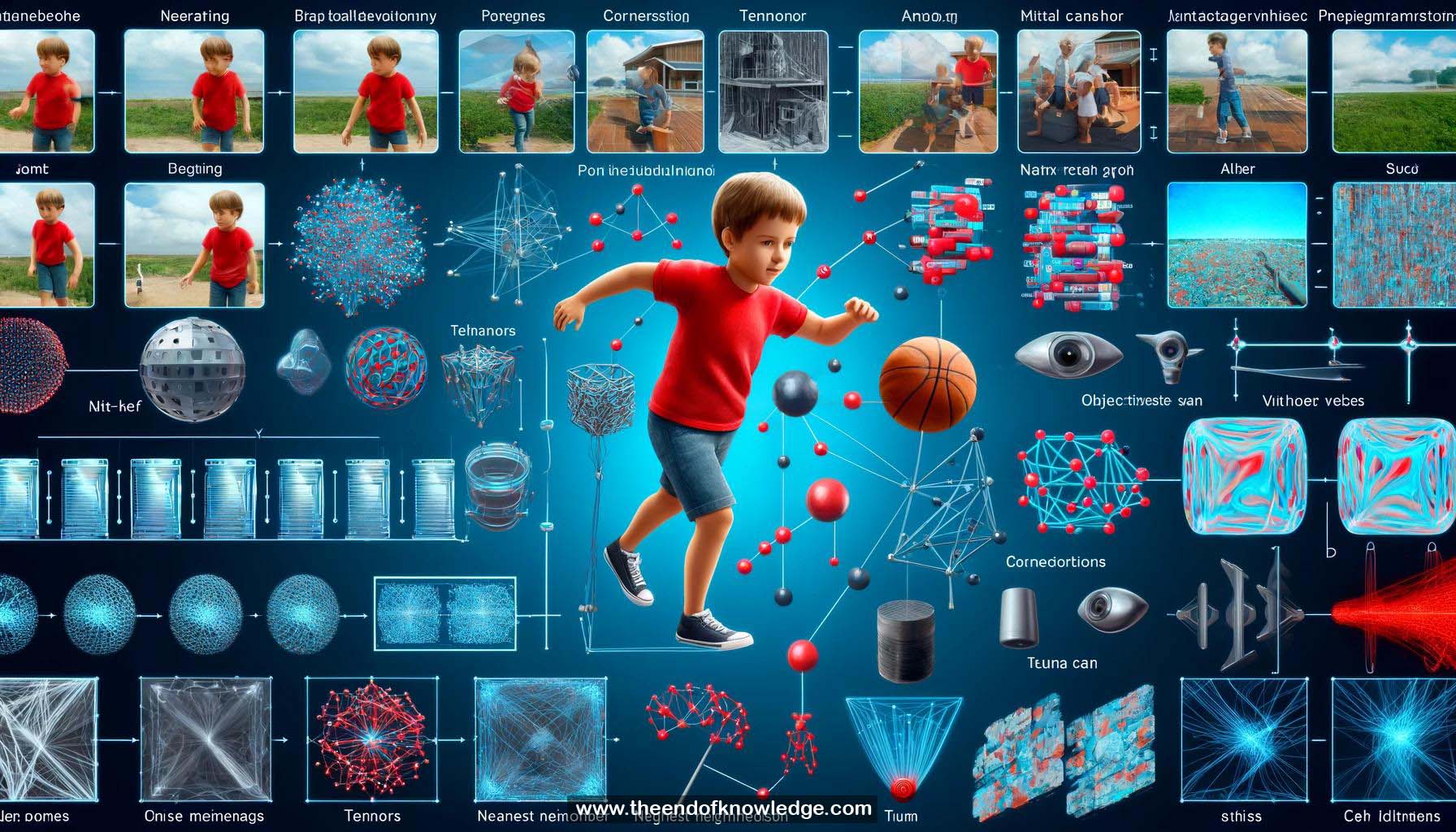

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4o | Llama 3:

Resumen:

1.- El video es un campo 2D que cambia con el tiempo con objetos que tienen correspondencias a través de los fotogramas.

2.- Las posiciones correspondientes tienen características visuales/semánticas similares y pueden abarcar rangos espaciales y temporales arbitrarios.

3.- Dada una posición, solo una pequeña porción de posiciones en otros fotogramas podría ser potencialmente la correspondencia (escasez e irregularidad).

4.- Se propone una nueva arquitectura de red neuronal para abordar las propiedades de correspondencia en videos.

5.- El tensor de representación de un video se trata como una nube de puntos en el espacio de características semánticas.

6.- Para cada punto, se encuentran los k vecinos más cercanos de otros fotogramas y se consideran como correspondencias potenciales (módulo CP).

7.- El módulo CP toma el tensor de representación de video como entrada y calcula la matriz de distancia de características por pares para obtener los índices de los k vecinos más cercanos.

8.- La capa de incrustación de correspondencia concatena vectores de características semánticas y ubicación espacial-temporal relativa, los procesa de manera independiente y aplica max pooling.

9.- El tensor de salida codifica la información dinámica del video después de que el max pooling selecciona la información más interesante.

10.- El módulo CP está integrado en la arquitectura C2D ResNet.

11.- Se realizaron estudios de ablación sobre el número y posición de los módulos CP y el valor de k.

12.- El método propuesto logra un mejor rendimiento con menos parámetros en comparación con trabajos anteriores en el conjunto de datos de cinética.

13.- Se logran resultados de vanguardia entre los trabajos publicados en conjuntos de datos centrados en el movimiento (Something-Something y Gesture) con menos parámetros.

14.- La visualización muestra que el módulo CP propone correspondencias razonables como baloncesto, lata de metal y pulgar.

15.- El módulo CP filtra los puntos de correspondencia incorrectos y mantiene los correctos durante el max pooling.

16.- El módulo CP realiza más cambios en las áreas en movimiento en el mapa de características.

17.- El código del método propuesto es de fuente abierta.

Bóveda del Conocimiento construida porDavid Vivancos 2024