>

>

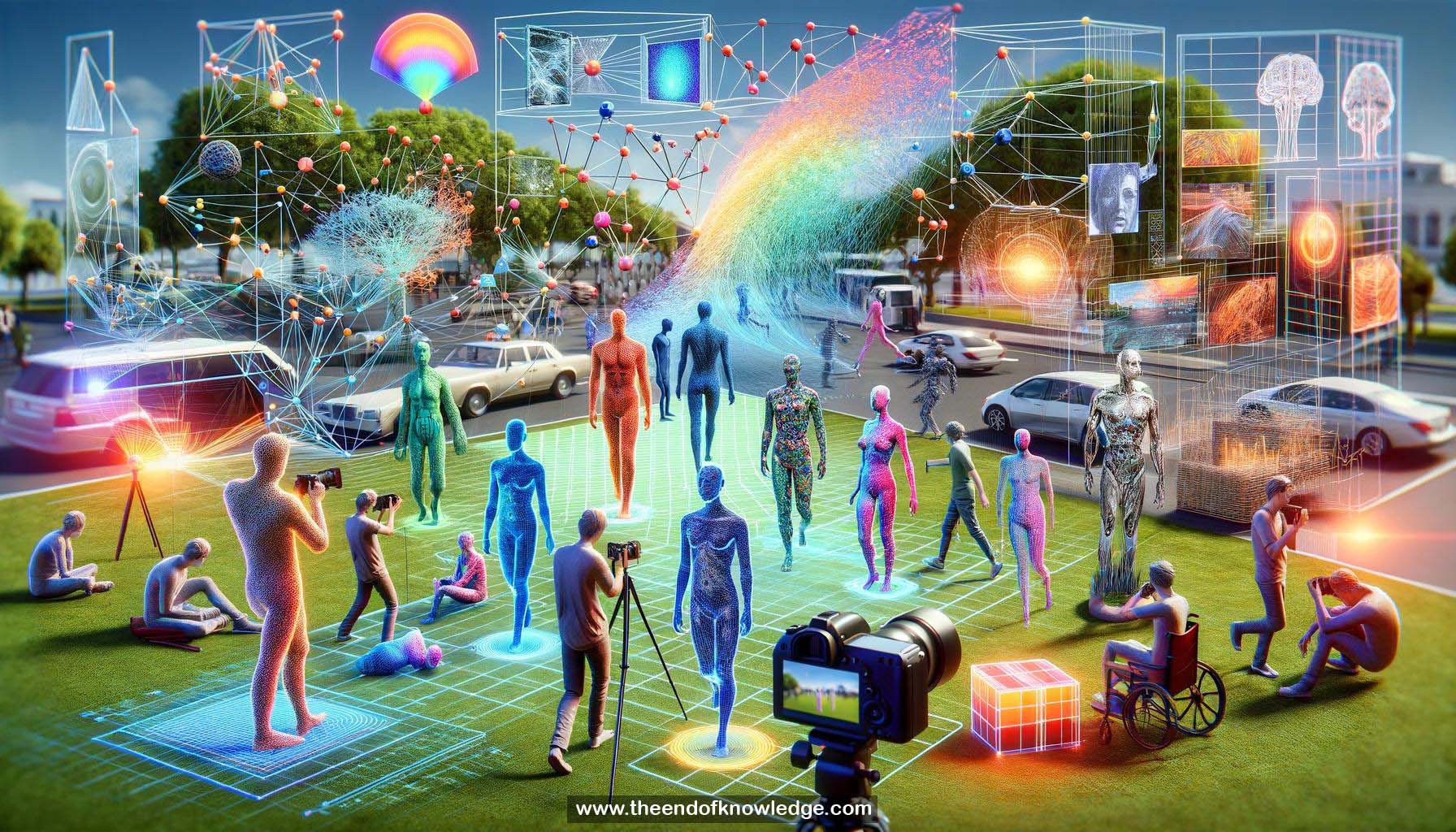

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4o | Llama 3:

Resumen:

1.- Aprendiendo la profundidad de personas en movimiento usando el conjunto de datos de personas congeladas (Mannequin Challenge).

2.- Los algoritmos de estéreo clásico asumen escenas rígidas, inadecuados para objetos en movimiento.

3.- Enfoque basado en datos usando el conjunto de datos Mannequin Challenge con personas estacionarias.

4.- El conjunto de datos abarca varias escenas, poses y número de personas.

5.- Estructura desde movimiento y estéreo de múltiples vistas recuperan poses de cámara y profundidades.

6.- Mapas de profundidad de estéreo de múltiples vistas usados como verdad de terreno para entrenar la red neuronal.

7.- La predicción de profundidad de imagen única ignora la información 3D en fotogramas vecinos.

8.- El flujo óptico entre el fotograma de referencia y los vecinos se convierte a profundidades usando poses de cámara.

9.- Las profundidades inexactas de personas en movimiento se enmascaran usando segmentación.

10.- Entradas completas del modelo: fotograma RGB, máscara de segmentación, profundidades de paralaje de movimiento, mapa de confianza.

11.- La red aprende a completar la profundidad humana enmascarada y refinar la profundidad de toda la escena.

12.- Modelo aplicado a videos de personas en movimiento durante la inferencia.

13.- Supera a los métodos de base solo RGB, estéreo de movimiento y de vista única en el conjunto de datos TUM RGBD.

14.- La comparación cualitativa muestra que las predicciones de profundidad del modelo son las más similares a la verdad de terreno.

15.- Predicciones de profundidad precisas y coherentes en clips de video regulares de internet.

16.- Las predicciones de profundidad permiten efectos visuales como desenfoque sintético y pausa de enfoque.

17.- Objetos sintéticos insertados y ocultos usando predicciones de profundidad.

18.- Síntesis de vista novedosa usando fotogramas cercanos y vecinos para llenar oclusiones.

19.- Regiones humanas efectivamente completadas usando predicciones de profundidad cuando la cámara y las personas se mueven libremente.

20.- Código y conjunto de datos liberados en el sitio web del proyecto.

Bóveda de Conocimiento construida porDavid Vivancos 2024