>

>

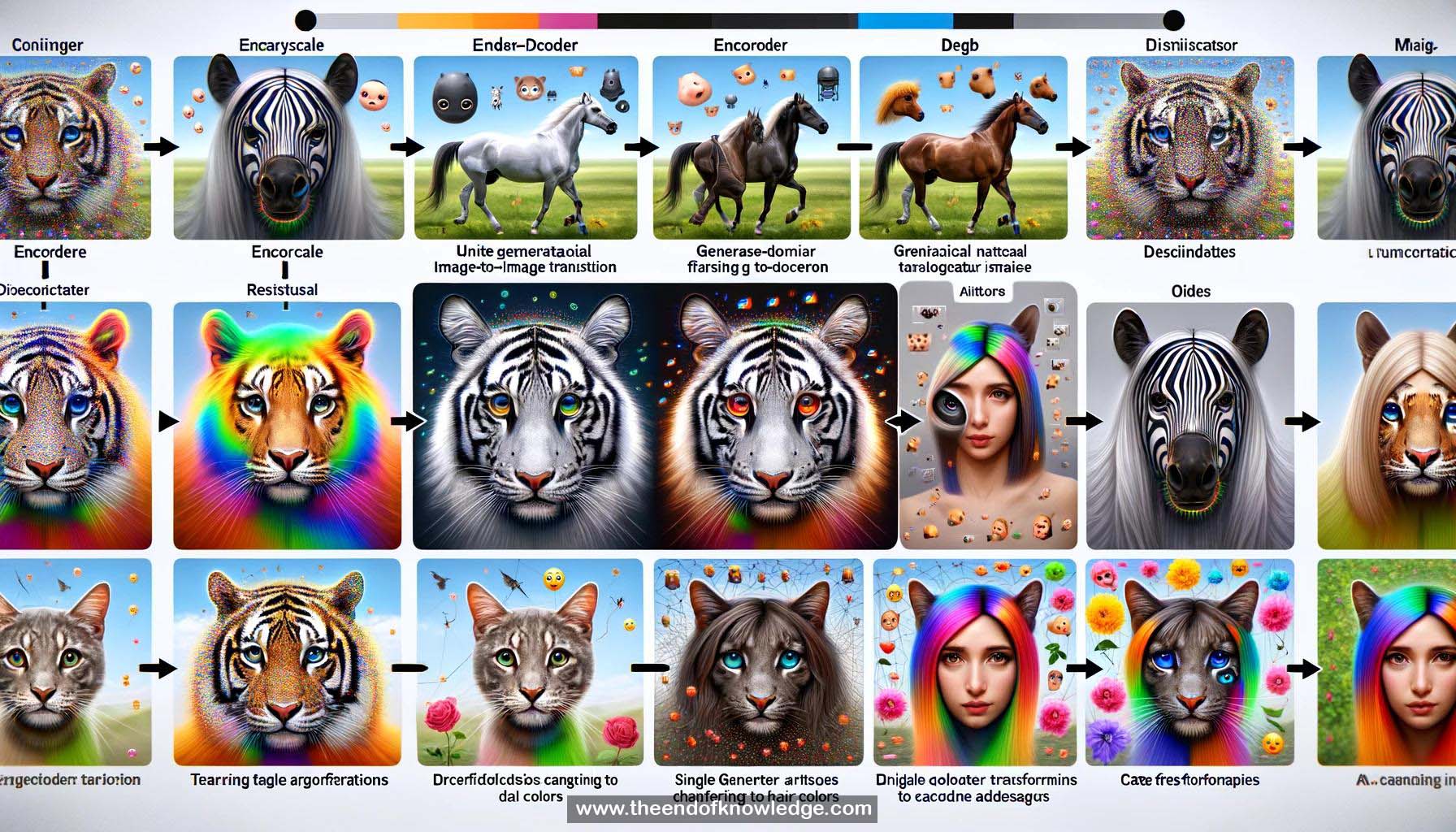

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4o | Llama 3:

Resumen:

1.- Traducción de imagen a imagen: Convertir imágenes del dominio fuente al objetivo.

2.- Traducción multidominio: Traducción entre múltiples dominios/atributos (ej. colores de cabello).

3.- Limitaciones de trabajos previos: Modelo separado por par de dominios; no escalable.

4.- StarGAN: Modelo unificado para traducción multidominio usando un solo generador.

5.- Entradas del generador: Imagen + etiqueta de dominio objetivo. Aprende a traducir flexiblemente al dominio objetivo.

6.- Arquitectura del generador: Codificador-decodificador con bloques residuales.

7.- Pérdida adversarial: Hace que las imágenes traducidas sean indistinguibles de las reales.

8.- Pérdida de clasificación de dominio: Asegura que las imágenes traducidas se clasifiquen correctamente al dominio objetivo.

9.- Pérdida de reconstrucción: Preserva el contenido de la imagen de entrada; solo cambia las partes relacionadas con el dominio.

10.- Transferencia de atributos faciales: Traducción de atributos como color de cabello, género, edad en el conjunto de datos CelebA.

11.- Comparación con bases: StarGAN supera a DIAT, CycleGAN, IcGAN en calidad visual.

12.- Efecto del aprendizaje multitarea: StarGAN se beneficia de aprender múltiples traducciones en un modelo.

13.- Estudio de usuarios de Mechanical Turk: Los usuarios prefirieron StarGAN sobre las bases por realismo, calidad de transferencia, preservación de identidad.

14.- Síntesis de expresiones faciales: Imposición de expresión facial objetivo en la imagen facial de entrada.

15.- Efecto limitado de aumento de datos: StarGAN aprovecha los datos de todos los dominios; las bases se limitan a 2 a la vez.

16.- Error de clasificación de expresiones faciales: Más bajo para StarGAN, indicando las expresiones más realistas.

17.- Número de parámetros: StarGAN necesita solo 1 modelo; las bases necesitan muchos (DIAT: 7, CycleGAN: 14).

18.- Implementación en Pytorch disponible.

19.- Sesgo del conjunto de datos: CelebA tiene principalmente celebridades occidentales; el rendimiento cae en rostros orientales y maquillaje.

20.- Aplicabilidad más allá de los rostros: Probado en transferencia de estilo (ej. Van Gogh) pero resultados no mostrados.

Bóveda de Conocimiento construida porDavid Vivancos 2024