>

>

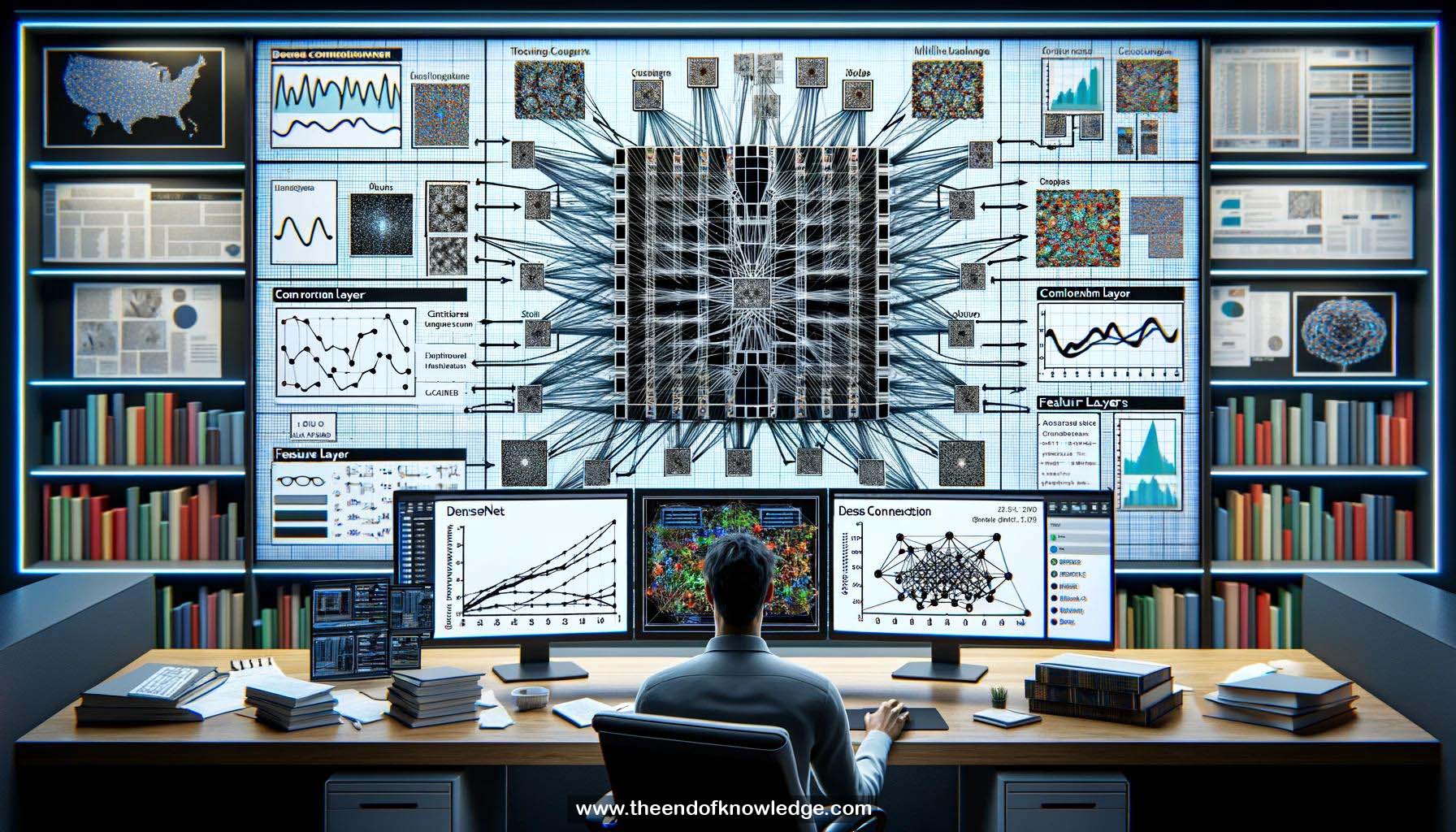

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4o | Llama 3:

Resumen:

1.- Conectividad densa: Conecta cada capa con todas las demás capas en una red, permitiendo la reutilización de características y un mejor flujo de información.

2.- Cuello de botella bajo: Las conexiones directas entre capas reducen la pérdida de información a medida que los datos pasan por la red.

3.- Modelos compactos: La conectividad densa permite capas más delgadas y modelos más compactos en comparación con arquitecturas tradicionales.

4.- Eficiencia computacional y de parámetros: Las redes densas requieren menos parámetros y menos cálculo por capa.

5.- Tasa de crecimiento (k): El número de mapas de características que cada capa en un bloque denso genera. Generalmente se mantiene pequeño.

6.- Concatenación de características: Las características de capas precedentes se concatenan juntas como entrada a capas posteriores en un bloque denso.

7.- Convoluciones 1x1: Se utilizan para reducir el número de mapas de características de entrada y mejorar la eficiencia de parámetros en capas más profundas.

8.- Bloques densos: Las redes densas se dividen en múltiples bloques densos, con capas de agrupamiento o convolución entre ellos.

9.- Supervisión profunda implícita: Las capas anteriores reciben más supervisión directa de la función de pérdida debido a la conectividad densa.

10.- Características diversificadas: Los mapas de características en redes densas tienden a ser más diversos ya que agregan información de todas las capas precedentes.

11.- Características de baja complejidad: Las redes densas mantienen características de complejidad variable, permitiendo que los clasificadores utilicen tanto características simples como complejas.

12.- Límites de decisión suaves: El uso de características de complejidad variable tiende a resultar en límites de decisión más suaves y una mejor generalización.

13.- Rendimiento en CIFAR-10: Las redes densas logran tasas de error más bajas con menos parámetros en comparación con ResNets.

14.- Rendimiento en CIFAR-100: Tendencias similares a CIFAR-10, con redes densas superando a ResNets.

15.- Rendimiento en ImageNet: Las redes densas logran una precisión similar a ResNets con aproximadamente la mitad de los parámetros y cálculos.

16.- Reducción del sobreajuste: Las redes densas son menos propensas al sobreajuste, especialmente cuando los datos de entrenamiento son limitados.

17.- Resultados de vanguardia: En el momento de la publicación, las redes densas lograron un rendimiento de vanguardia en los conjuntos de datos CIFAR.

18.- DenseNet multiescala: Una extensión de las redes densas que aprende características en múltiples escalas para una inferencia más rápida.

19.- Conexiones densas en cada escala: Las redes densas multiescala introducen conectividad densa dentro de cada escala de características.

20.- Múltiples clasificadores: Las redes densas multiescala adjuntan clasificadores a capas intermedias para permitir una salida temprana.

21.- Umbral de confianza: Durante la inferencia, los ejemplos más fáciles pueden salir temprano basado en la confianza de los clasificadores intermedios.

22.- Inferencia más rápida: Las redes densas multiescala logran una inferencia 2.6x más rápida que ResNets y 1.3x más rápida que las redes densas regulares.

23.- Código y modelos de código abierto: Los autores publicaron su código y modelos preentrenados en GitHub.

24.- Implementaciones de terceros: Muchas implementaciones independientes de redes densas estuvieron disponibles tras la publicación.

25.- Implementación eficiente en memoria: Los autores publicaron un informe técnico detallando cómo implementar redes densas de manera más eficiente en memoria.

Bóveda de Conocimiento construida porDavid Vivancos 2024