>

>

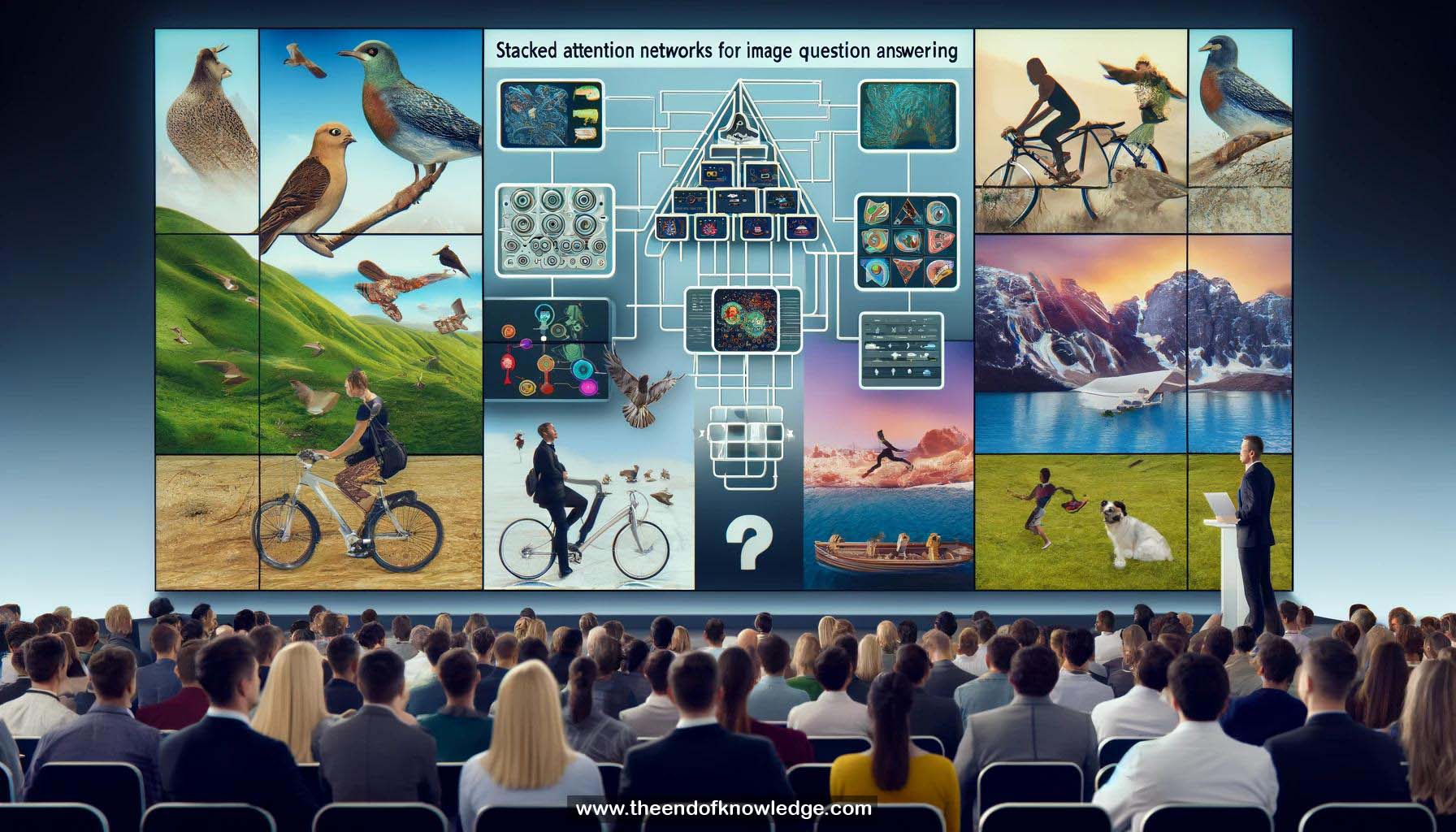

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4o | Llama 3:

Resumen:

1.- Respuesta a Preguntas de Imágenes (IQA): Responder preguntas en lenguaje natural basadas en el contenido de una imagen.

2.- Aplicaciones de IQA: Ayudar a personas con discapacidad visual a entender su entorno.

3.- Desafíos de IQA: Requiere entender las relaciones entre objetos y enfocarse en regiones relevantes.

4.- Razonamiento en varios pasos: Enfocar progresivamente para inferir la respuesta.

5.- Modelo de Red de Atención Apilada (SAN): 4 pasos - codificar pregunta, codificar imagen, atención multinivel, predecir respuesta.

6.- Codificación de imagen: Usar la última capa convolucional de la red VGG para capturar características espaciales.

7.- Codificación de pregunta: Usar LSTM o CNN para capturar la estructura semántica y sintáctica.

8.- Primera capa de atención: Calcula la correlación entre las entidades de la pregunta y las regiones de la imagen.

9.- Agregar características de imagen ponderadas: Suma características de imagen basadas en la atención.

10.- Agrupación multimodal: Combina características de imagen y texto depuradas.

11.- Segunda capa de atención: Enfoca más en las regiones relevantes para la respuesta y suprime el ruido.

12.- Predicción de respuesta: Se trata como una clasificación de 400 vías usando características multimodales.

13.- Referencias: Evaluado en los conjuntos de datos de Visual Question Answering (VQA), CoCoQA, DAQUAR.

14.- Resultados de VQA: Mejora significativa sobre las líneas base, especialmente para preguntas del tipo "qué es/color".

15.- Impacto de las capas de atención: Usar 2 capas de atención supera significativamente a usar 1 capa.

16.- LSTM vs CNN para codificación de preguntas: Funcionan de manera similar.

17.- Ejemplos cualitativos: El modelo aprende a enfocarse en las regiones relevantes e ignorar las irrelevantes.

18.- Análisis de errores: 78% presta atención a la región correcta, 42% aún predice la respuesta incorrecta.

19.- Tipos de errores: Respuestas ambiguas, errores de etiqueta.

20.- Ejemplos de errores: Confusión entre objetos similares, errores en las etiquetas de verdad.

21.- Aumento del interés en IQA: Muchos artículos relacionados en la conferencia.

22.- Comparación con subtitulación: IQA requiere entender detalles sutiles y razonamiento enfocado.

23.- Motivación de SAN: Proporcionar capacidad para razonamiento progresivo, multinivel.

24.- Fundamentación visual: SAN permite una fundamentación más clara del razonamiento en la imagen.

25.- Código compartido: Disponible en GitHub.

Bóveda del Conocimiento construida porDavid Vivancos 2024