>

>

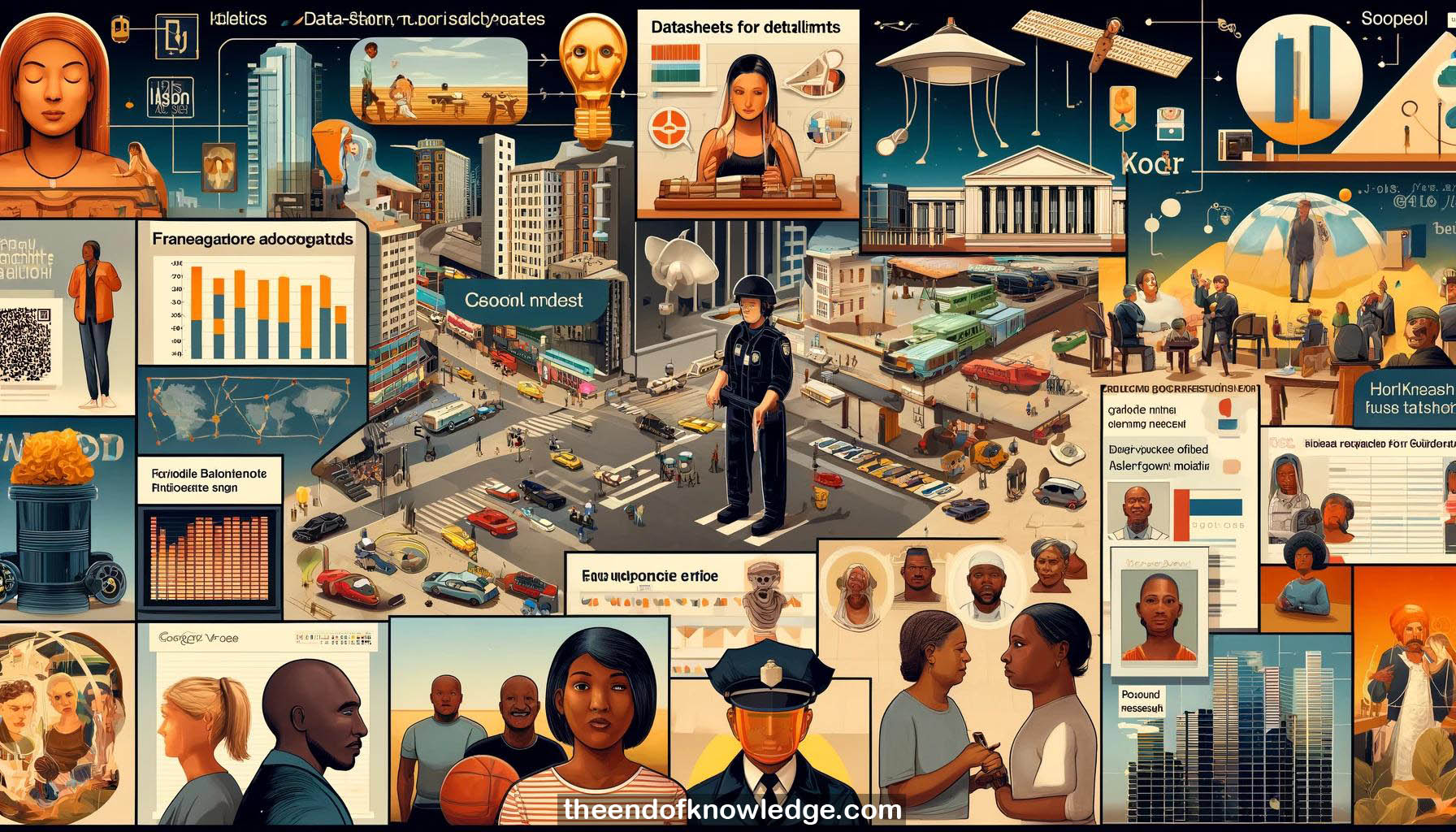

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4o | Llama 3:

Resumen:

1.- Gebru utilizó imágenes de Google Street View para predecir demografía como educación, patrones de votación y segregación de ingresos en ciudades de EE.UU.

2.- Los datos disponibles públicamente utilizados para análisis predictivos pueden ser beneficiosos pero también problemáticos si no se consideran cuidadosamente.

3.- Los algoritmos de predicción de crímenes entrenados con datos policiales sesgados pueden exacerbar los sesgos e inequidades sociales a través de bucles de retroalimentación descontrolados.

4.- Actualmente se utilizan algoritmos predictivos en escenarios de alto riesgo como la evaluación de inmigración, pero las herramientas de IA no son lo suficientemente robustas para esto.

5.- Facebook tradujo incorrectamente un post árabe de "buenos días", lo que llevó al arresto injusto de alguien, mostrando errores costosos en la traducción de IA.

6.- Gebru analiza cómo el reconocimiento facial es utilizado por las fuerzas del orden de manera no regulada, con la mitad de los adultos de EE.UU. en bases de datos.

7.- Dos preguntas clave: ¿debería usarse el reconocimiento facial de esta manera y son las herramientas actuales de IA lo suficientemente precisas para usos de alto riesgo?

8.- Gebru y Joy Buolamwini encontraron que las tasas de error en el análisis facial se acercaban al azar para mujeres de piel más oscura, desempeñándose peor en este grupo.

9.- Esto ocurrió porque los conjuntos de datos de entrenamiento estaban abrumadoramente compuestos por hombres de piel más clara, por lo que crearon un conjunto de datos más equilibrado.

10.- La raza es un constructo social inestable; se utilizó el tipo de piel en su lugar como una característica más significativa en su investigación de análisis facial.

11.- Es importante traer antecedentes diversos de investigadores; Gebru y Buolamwini, como mujeres negras, entendieron los impactos del colorismo.

12.- Su artículo llevó a llamados para la regulación de herramientas de análisis facial y reacción de las empresas. Las lecciones incluyeron:

13.- Los investigadores no pueden ignorar los problemas sociales; los grupos vulnerables son a menudo injustamente atacados por la tecnología.

14.- Los grupos que venden herramientas de análisis facial a las fuerzas del orden rara vez incluyen poblaciones vulnerables sujetas a la tecnología.

15.- Las conferencias de aprendizaje automático carecen abrumadoramente de mujeres y minorías; quienes desarrollan la tecnología deben representar el mundo que impacta.

16.- Un seguimiento mostró que Rekognition de Amazon tenía sesgos de tipo de piel similares; el autor principal casi dejó el campo debido a la discriminación hasta encontrar Black in AI.

17.- Gebru cofundó Black in AI para abordar problemas estructurales en el campo, aunque no era su enfoque de investigación original.

18.- No hay leyes que restrinjan el uso de APIs de IA; el sistema de traducción defectuoso puede usarse en escenarios de alto riesgo sin supervisión.

19.- San Francisco recientemente prohibió el uso gubernamental de reconocimiento facial, pero faltan regulaciones y estándares comprensivos.

20.- Otras industrias tienen estándares/hojas de datos que especifican casos de uso ideales y limitaciones; los conjuntos de datos y modelos de IA necesitan documentación similar.

21.- Algunas herramientas de IA como los clasificadores de género pueden ser inherentemente dañinas para grupos como las personas transgénero y no deberían existir.

22.- El equipo de Gebru propuso "Hojas de Datos para Conjuntos de Datos" y "Tarjetas de Modelos" para documentar características de conjuntos de datos y modelos, sesgos, usos apropiados.

23.- El sesgo entra en la IA en cada etapa: formulación del problema, recopilación de datos, arquitectura del modelo, análisis de impacto de implementación.

24.- Las preguntas de "funcionamiento de la IA" dependen de "para quién"--por ejemplo, si los clasificadores de género "funcionan" pero dañan a las personas trans.

25.- Los problemas perseguidos dependen de quién los formula; Gebru está analizando la evolución del apartheid espacial en Sudáfrica a través de imágenes satelitales.

26.- Los colegas africanos fueron empoderados para impulsar proyectos localmente relevantes como el monitoreo de enfermedades de la yuca cuando se les dieron recursos y agencia.

27.- Esto contrasta con la "investigación paracaidista/helicóptero" donde los forasteros explotan datos/conocimientos comunitarios sin centrar sus voces o proporcionar beneficios recíprocos.

28.- Centrar las comunidades afectadas hace una ciencia mejor y más ética que los enfoques extractivos.

29.- A medida que la IA se utiliza para el bien social, las comunidades impactadas deben tener una voz central en el proceso.

30.- Asimismo, en la ética de la IA, las voces de aquellos afectados por la tecnología deben estar al frente.

Bóveda de Conocimiento construida porDavid Vivancos 2024