>

>

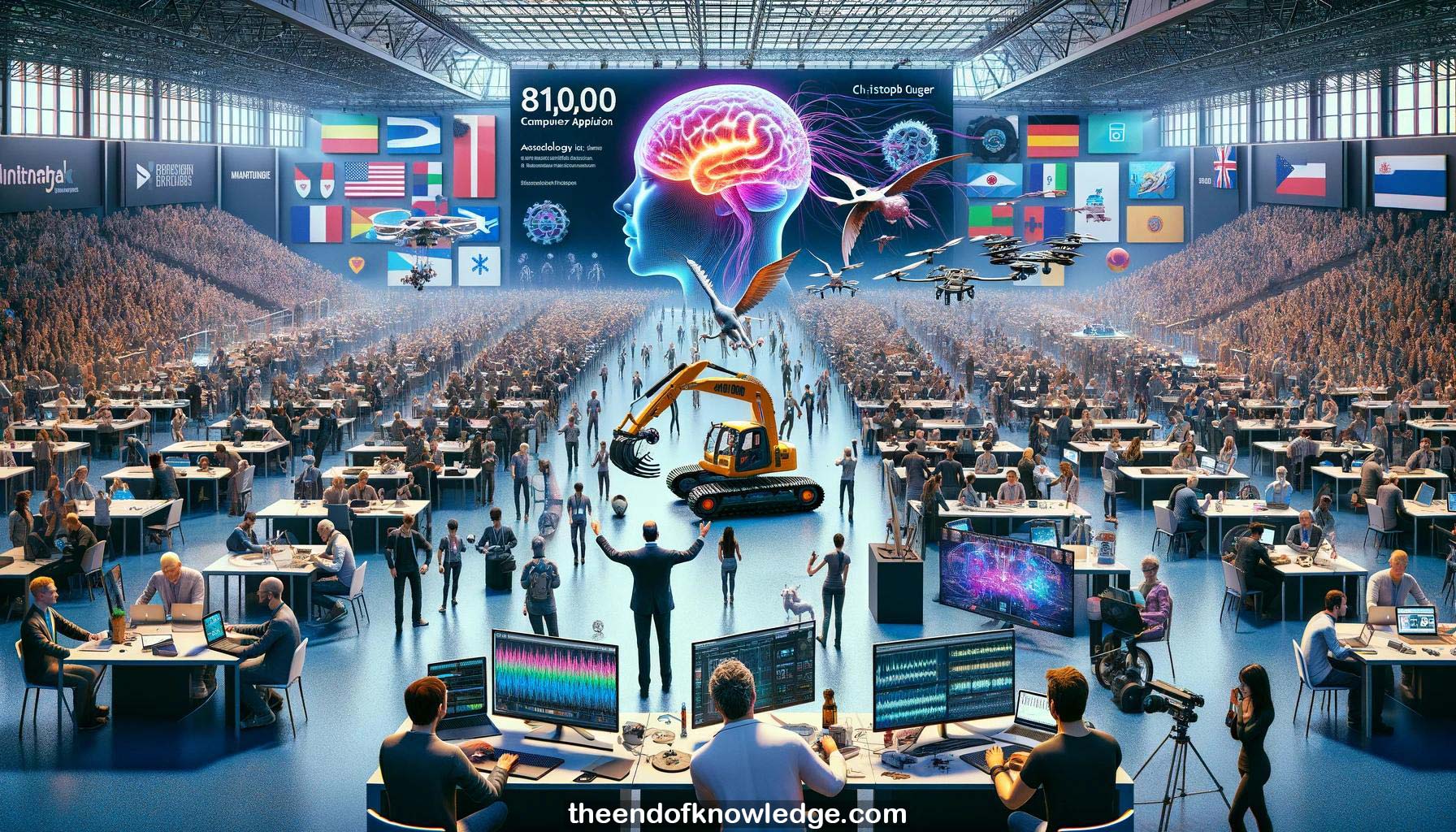

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4 | Llama 3:

Resumen:

1.- BCI & Neurotecnología Escuela de Primavera 2024 tiene 81,000 asistentes de 118 países con 140 horas de educación y 85 ponentes.

2.- Hoy es el día del hackathon con 24 horas para crear aplicaciones BCI. Es un evento mundial con un jurado experto.

3.- Los institutos anfitriones abarcan muchos países, incluyendo Austria, Países Bajos, Dinamarca, EAU, Canadá, EE.UU., China, Italia, Colombia, Suecia, Polonia y Australia.

4.- Los miembros del jurado provienen de la Universidad de Ámsterdam, Universidad de Timisoara, Bootsen Italia, Queen's University Canadá y Universidad de Tennessee EE.UU.

5.- Los premios incluyen $1000 para el primer lugar y certificados para el segundo y tercero. Las categorías cubren juegos, programación, control de hogar inteligente, arte, etc.

6.- Los proyectos pasados involucraron auriculares de máquina de coser, manos protésicas, drones, pintura de sueños, rehabilitación VR/AR, robots esféricos, control de excavadoras y pintura robótica.

7.- Christoph Guger da la bienvenida a los asistentes y resume estadísticas. Muestra un proyecto controlando una excavadora con un unicorn speller.

8.- Martin Spuler de G.Tec da una presentación sobre las interfaces de hardware y software del sistema de interfaz cerebro-computadora unicorn.

9.- El amplificador unicorn tiene 8 canales EEG con resolución de 24 bits y electrodos híbridos secos/gel. Funciona directamente.

10.- El unicorn es utilizado por muchas instituciones de investigación en todo el mundo. Las características clave son resolución de 24 bits, electrodos híbridos y colocación inteligente de electrodos.

11.- El software unicorn abarca desde APIs hasta aplicaciones terminadas para investigación, arte, robótica, educación y más. Soporta muchas plataformas.

12.- El preprocesamiento de EEG implica filtrado de paso de banda y de muesca para eliminar el ruido y enfocarse en frecuencias de interés de 0.5-50 Hz.

13.- Los ritmos EEG como delta, theta, alfa, beta y gamma reflejan diferentes estados cerebrales desde el sueño profundo hasta la alta alerta.

14.- Los potenciales evocados visualmente como P300, SSVEP y c-VEP utilizan estímulos visuales para provocar respuestas cerebrales detectables para el control BCI.

15.- Una demostración en vivo muestra la aplicación del auricular unicorn, comprobando impedancias y visualizando datos EEG limpios con los ojos abiertos/cerrados.

16.- El Unicorn Speller utiliza P300 para seleccionar caracteres parpadeando filas y columnas. Se puede usar para controlar otras aplicaciones.

17.- El Blondie Checker clasifica imágenes basándose en la detección de respuestas P300 cuando aparece un rostro rubio, mostrando que el cerebro detecta estímulos objetivo.

18.- La interfaz del motor de juegos Unity permite crear juegos BCI que combinan control de teclado con control SSVEP del entorno.

19.- Demostración en vivo del control SSVEP en el juego Unity y discusión de herramientas de desarrollo y opciones de configuración en el marco Unity.

20.- Consejos para el diseño de juegos BCI incluyen no tener demasiados estímulos simultáneos, ajustar parámetros del clasificador y combinar modalidades de entrada.

21.- El paquete Unity para Unicorn se instala a través del gestor de paquetes Unity. Los prefabricados facilitan la integración en proyectos.

22.- La calidad de la señal, el gestor BCI y los controladores Flash manejan el núcleo de la tubería BCI. Los desarrolladores pueden personalizar la UI y los objetos.

23.- El modo simulador permite probar juegos sin conectar el hardware BCI. El marco soporta el envío de datos a otras aplicaciones vía LSL.

24.- Python, C#, C y otras APIs permiten la integración flexible de Unicorn en aplicaciones personalizadas siguiendo una plantilla básica de adquisición de datos.

25.- Conjuntos de datos de rehabilitación de ictus (imaginación motora), conjuntos de datos P300, conjuntos de datos SSVEP y conjuntos de datos de pacientes no responsivos (P300 vibrotáctil) están disponibles.

26.- Conjuntos de datos ECoG de clasificación de poses de mano y visualización de vídeos con categorización de estímulos visuales proporcionan una perspectiva BCI invasiva.

27.- El paradigma de rehabilitación de ictus proporciona retroalimentación en bucle cerrado vía FES, con conjuntos de datos que muestran cambios pre/post terapia. Se describe una tubería.

28.- El P300 speller utiliza parpadeo de filas/columnas para detectar la letra objetivo. Se proporcionan conjuntos de datos de 5 sujetos grabados con Unicorn.

29.- Conjuntos de datos SSVEP con 4 frecuencias (9-15 Hz) de 2 sujetos viendo estímulos parpadeantes se detallan, incluyendo un clasificador LDA.

30.- Los datos de pacientes no responsivos utilizan un paradigma P300 táctil de 3 clases (muñeca objetivo, muñeca no objetivo, tobillo distractor) para evaluar el seguimiento de comandos.

31.- Las diferencias de precisión entre sesiones para pacientes no responsivos justifican un análisis adicional para posibles biomarcadores explicativos.

32.- El conjunto de datos invasivo de poses de mano, grabado desde una cuadrícula ECoG de alta densidad durante una tarea de piedra-papel-tijera, abarca la corteza sensoriomotora.

33.- La actividad de alta frecuencia (>50 Hz) proporciona una señal robusta para las poses de mano, con datos muestreados a 1.2 kHz. Se comparten tuberías de referencia.

34.- Otro conjunto de datos ECoG involucra a un paciente viendo un vídeo de un paseo por el jardín con varias categorías visuales (caras, objetos, dígitos, etc).

35.- Analizar los datos ECoG del paseo por el jardín podría revelar electrodos discriminativos de categorías visuales, por ejemplo, en el lóbulo temporal.

36.- A continuación, los asistentes se moverán a Discord y otros foros para hacer networking y comenzar el hackathon. Se están distribuyendo conjuntos de datos y enlaces.

37.- El hackathon reanuda presentaciones a las 4pm hora de Viena con NeuroTechX, luego presentaciones de equipos y premios mañana por la tarde.

38.- Muchos equipos están participando, lo cual es emocionante. Christoph espera con interés los resultados de los proyectos presentados mañana.

Bóveda de Conocimiento construida por David Vivancos 2024