>

>

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4 | Gemini Adv | Llama 3:

Resumen:

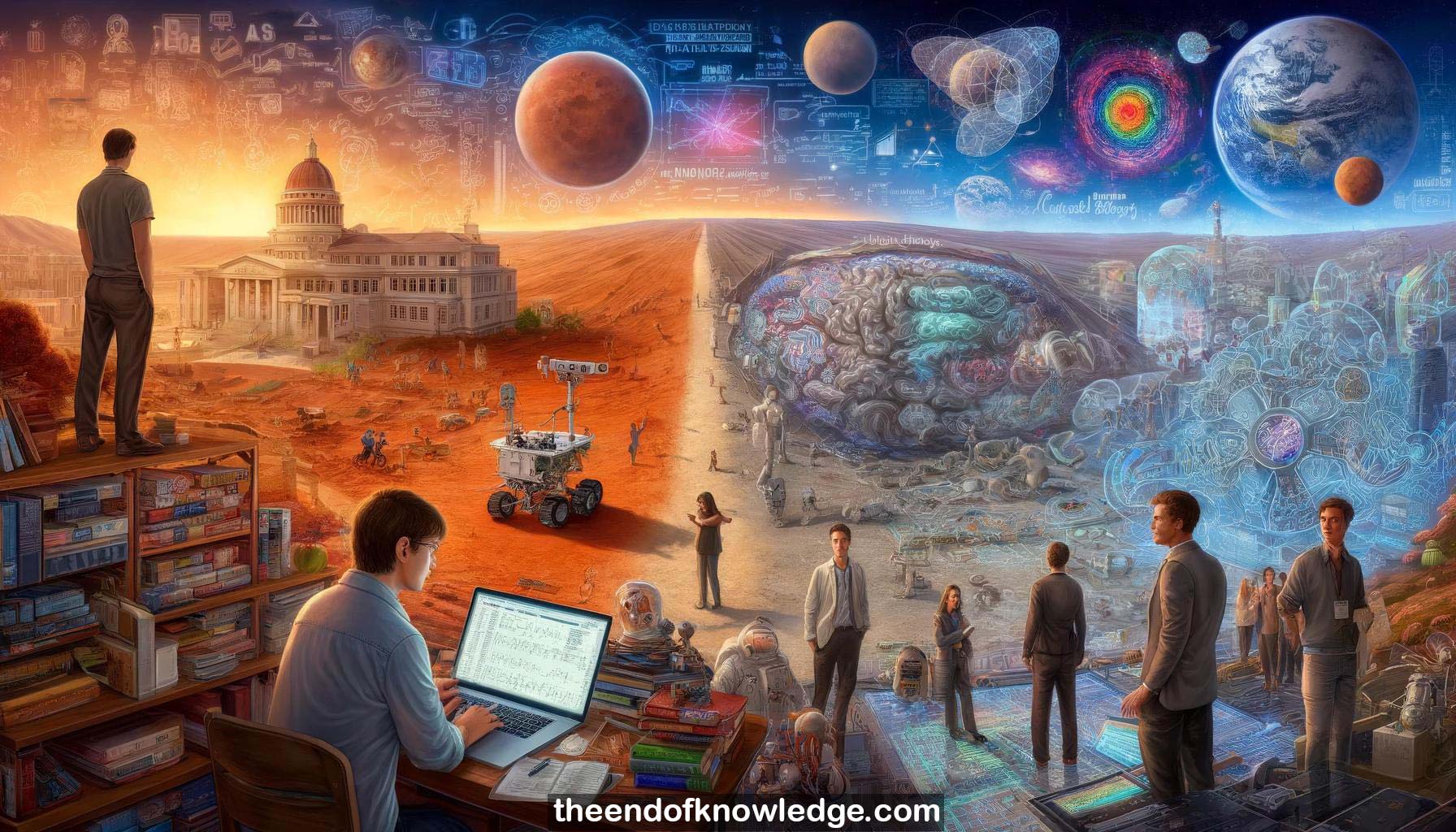

1.-La trayectoria de investigación de Jascha incluyó física en Cornell, trabajo en rovers de Marte en NASA JPL, y neurociencia computacional en Berkeley.

2.-La charla cubrirá tres temas principales: los optimizadores aprendidos están comenzando a funcionar bien, transformarán el entrenamiento de modelos, y necesitan más investigación fundamental.

3.-A pesar de la incertidumbre, la IA está transformando el mundo rápidamente y las decisiones tempranas de individuos pueden tener grandes consecuencias, para bien o para mal.

4.-Se dan ejemplos de pequeñas decisiones individuales que tuvieron grandes impactos, como los protocolos de correo electrónico estandarizados y compartir libremente la línea celular HeLa.

5.-Jascha insta a la intencionalidad y reflexión en las elecciones de investigación en IA, ya que los individuos tienen un inmenso poder para dar forma al futuro de la IA.

6.-Se introducen los optimizadores aprendidos: aprender la regla de actualización de parámetros usando un bucle externo para optimizar el proceso de optimización interno.

7.-Las redes neuronales por parámetro son una elección simple de arquitectura para optimizadores aprendidos, con capas lineales que se reducen a variantes de descenso de gradiente.

8.-Se describen los desafíos clave de investigación para optimizadores aprendidos: caos/instabilidad, costo computacional, generalización a nuevas tareas.

9.-El caos resulta de los sistemas dinámicos anidados. Los parámetros ideales del optimizador están al borde de la inestabilidad del entrenamiento del bucle interno.

10.-Los paisajes de pérdida para la aplicación de optimizadores de múltiples pasos se vuelven extremadamente caóticos, cambiando a una escala menor que un píxel, dificultando la optimización externa.

11.-Suavizar el paisaje de pérdida externo promediando sobre perturbaciones aleatorias de los parámetros del optimizador ayuda a domar el caos.

12.-Las estrategias evolutivas permiten calcular gradientes de la pérdida suavizada. El muestreo antitético reduce drásticamente la varianza. Los gradientes de reparametrización tienen una varianza prohibitiva.

13.-El entrenamiento externo es muy costoso debido a muchos pasos internos por paso externo y a la alta varianza de los gradientes ES. Los desenrollados internos parciales ayudan.

14.-La generalización a nuevas tareas requiere grandes conjuntos de meta-entrenamiento diversos y aumento de datos. Generalizar a través de la escala del problema es un desafío abierto.

15.-Temas de arquitectura útiles: proporcionar a los optimizadores muchas características, equilibrar sobrecarga vs rendimiento, usar cómputo jerárquico, normalizar características, construir estabilidad.

16.-La arquitectura ideal del optimizador aprendido aún está por determinarse y es un problema de investigación abierto.

17.-Velo, el optimizador aprendido SOTA actual, se propuso trabajar en todo el entrenamiento de redes neuronales sin ajuste de hiperparámetros, usando gran cómputo.

18.-En tareas de referencia de ML no vistas, Velo igualó o superó las bases ajustadas en 5/6 tareas sin ajuste. Tuvo dificultades en la tarea GNN fuera de distribución.

19.-Velo supera a los optimizadores estándar bien ajustados en métricas de aceleración vs % de tareas. El comportamiento en el peor de los casos es razonable, no catastrófico.

20.-Velo hace un uso más eficiente de grandes tamaños de lote que otros métodos de primer orden. Se adapta a la longitud del entrenamiento y al tipo de parámetro.

21.-Velo falla en modelos muy grandes fuera de distribución, largas ejecuciones de entrenamiento y tareas de RL no vistas durante el meta-entrenamiento.

22.-Se describen muchos otros enfoques para optimizadores aprendidos: desacoplar objetivos meta e internos, especializarse en tareas estrechas, RL, control de hiperparámetros, etc.

23.-A medida que aumentan el cómputo y los datos de tareas, se espera que los optimizadores aprendidos, las pérdidas y las arquitecturas superen a los diseñados a mano, causando una "revolución de meta-aprendizaje".

24.-El código y los ejemplos están disponibles para entrenar optimizadores aprendidos simples. El escalado sigue siendo un desafío mejor adecuado para laboratorios bien financiados actualmente.

25.-Los optimizadores aprendidos descubren implícitamente técnicas utilizadas en optimizadores diseñados a mano. Se necesitan experimentos de generalización más rigurosos a través de tipos de problemas.

26.-Integrar información de curvatura es una dirección prometedora para que los optimizadores aprendidos mejoren los optimizadores de segundo orden históricamente frágiles.

27.-Los optimizadores aprendidos simples pueden entrenarse en un colab en minutos. Hacer los métodos más eficientes es un problema clave de investigación.

28.-La IA está progresando rápidamente y los investigadores individuales tienen un inmenso poder para dar forma a su trayectoria para bien o para mal a través de sus elecciones.

29.-Los optimizadores aprendidos están comenzando a superar a los diseñados a mano y probablemente transformarán cómo se entrenan los modelos a medida que aumentan el cómputo y los datos.

30.-Quedan muchos desafíos abiertos en los optimizadores aprendidos, incluyendo estabilidad, generalización, eficiencia computacional y arquitecturas ideales, lo que lo convierte en un área de investigación fascinante.

Bóveda de Conocimiento construida porDavid Vivancos 2024