>

>

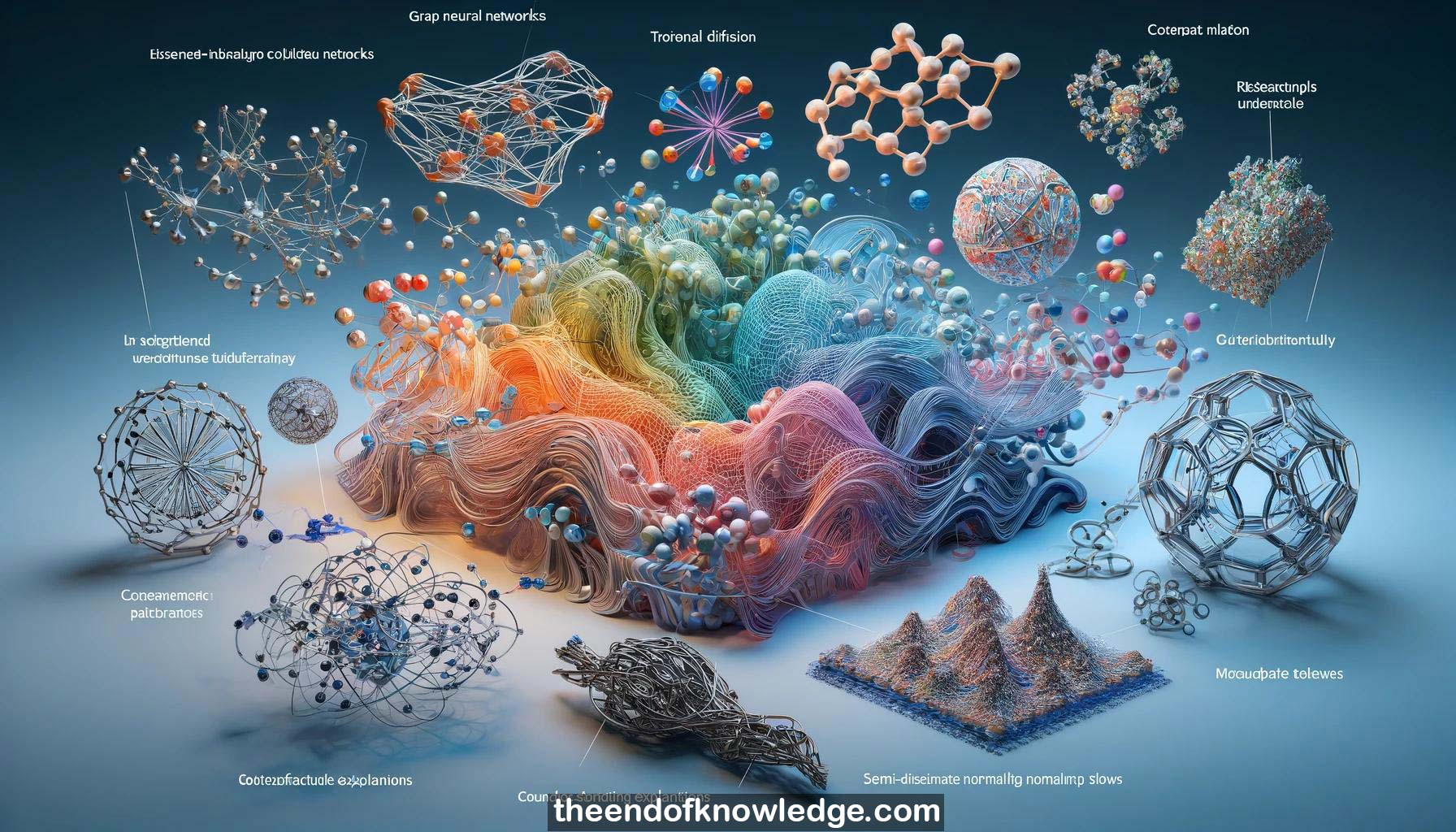

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4 | Gemini Adv | Llama 3:

Resumen:

1.-Max Welling discutió el aprendizaje profundo para moléculas y PDEs usando redes neuronales de grafos con propiedades de equivarianza.

2.-Las redes neuronales de grafos equivariante combinan redes neuronales de grafos con equivarianza para modelar estructuras moleculares 3D.

3.-Las redes neuronales de grafos para PDEs permiten resolver muchos tipos de PDEs con plantillas aprendidas y marcha de frecuencia.

4.-La generación condicional sigue siendo un desafío: las moléculas generadas deben ser químicamente estables, no tóxicas y sintetizables.

5.-Ellen Zhong presentó cryo-DRAGON, un modelo generativo profundo para reconstruir estructuras de proteínas 3D a partir de imágenes cryo-EM 2D.

6.-Cryo-DRAGON usa redes neuronales basadas en coordenadas, una arquitectura VAE e inferencia de pose exacta para modelar estructuras de proteínas heterogéneas.

7.-Cryo-DRAGON se utilizó para descubrir nuevas estructuras de proteínas y visualizar la dinámica continua de proteínas a partir de datos cryo-EM.

8.-El trabajo futuro incluye reconstrucción ab initio, análisis exploratorio de datos, evaluación comparativa e incorporación de información de secuencia/estructura de proteínas.

9.-Tristan Deleu introdujo DAG G-Flow Nets para el aprendizaje de estructura bayesiana de redes bayesianas.

10.-DAG G-Flow Nets proporcionan una aproximación de la distribución posterior de DAGs usando redes de flujo generativo.

11.-Se introdujo una nueva condición de balance detallado para redes de flujo G con solo estados terminales.

12.-DAG G-Flow Nets superaron a otros métodos de aprendizaje de estructura bayesiana tanto en datos sintéticos como reales.

13.-Bowen Jing y Gabriel Corso presentaron difusión torsional, un modelo de difusión para la generación de conformaciones moleculares.

14.-La difusión torsional restringe la difusión a los ángulos de torsión, reduciendo en gran medida la dimensionalidad en comparación con la difusión de coordenadas atómicas.

15.-La difusión torsional aprovecha el teorema de corte de Fourier y funciones especiales en el hipertoro para la generación equivariante.

16.-La difusión torsional superó significativamente a los métodos existentes basados en reglas y de aprendizaje automático para la generación de conformaciones.

17.-Gimhani Eriyagama introdujo MACE, un método de explicación contrafactual agnóstico al modelo para explicar predicciones de modelos de caja negra arbitrarios.

18.-MACE genera un espacio químico local alrededor de una molécula de entrada y etiqueta contrafactuales usando el modelo de caja negra.

19.-Las explicaciones contrafactuales proporcionan ideas intuitivas y accionables sobre las predicciones del modelo para moléculas similares a medicamentos.

20.-El paquete de código abierto XMol proporciona una implementación fácil de usar del algoritmo MACE.

21.-Prateek Tiwari presentó modelos probabilísticos de difusión de desruido (DDPMs) para generar conformaciones moleculares sensatas y trayectorias.

22.-Los DDPMs aprenden distribuciones sobre moléculas difundiéndose al ruido y luego aprendiendo a desruido muestras.

23.-Los DDPMs capturan la distribución de Boltzmann y generan muestras de nuevas regiones del paisaje energético.

24.-Para modelar dinámicas no markovianas a partir de datos de series temporales, los LSTMs de muestreo de trayectorias proporcionan resultados de última generación.

25.-Agregar restricciones basadas en la física a los LSTMs de muestreo de trayectorias mejora la calidad de la generación al reducir el ruido de los datos.

26.-Bahijja Tolulope Raimi presentó DDRM, un método no supervisado para resolver problemas inversos usando modelos de difusión preentrenados.

27.-DDRM opera en el espacio espectral, permitiendo la desruido y la pintura para matrices de degradación general.

28.-DDRM supera a los solucionadores de problemas inversos no supervisados anteriores tanto en PSNR como en calidad perceptual.

29.-Ricky T.Q. Chen introdujo flujos normalizadores semi-discretos a través de teselación de Voronoi diferenciable para modelar soportes acotados.

30.-La teselación de Voronoi permite el particionamiento flexible de un espacio continuo para la desquantización y el modelado de mezclas disjuntas.

Bóveda de Conocimiento construida porDavid Vivancos 2024