>

>

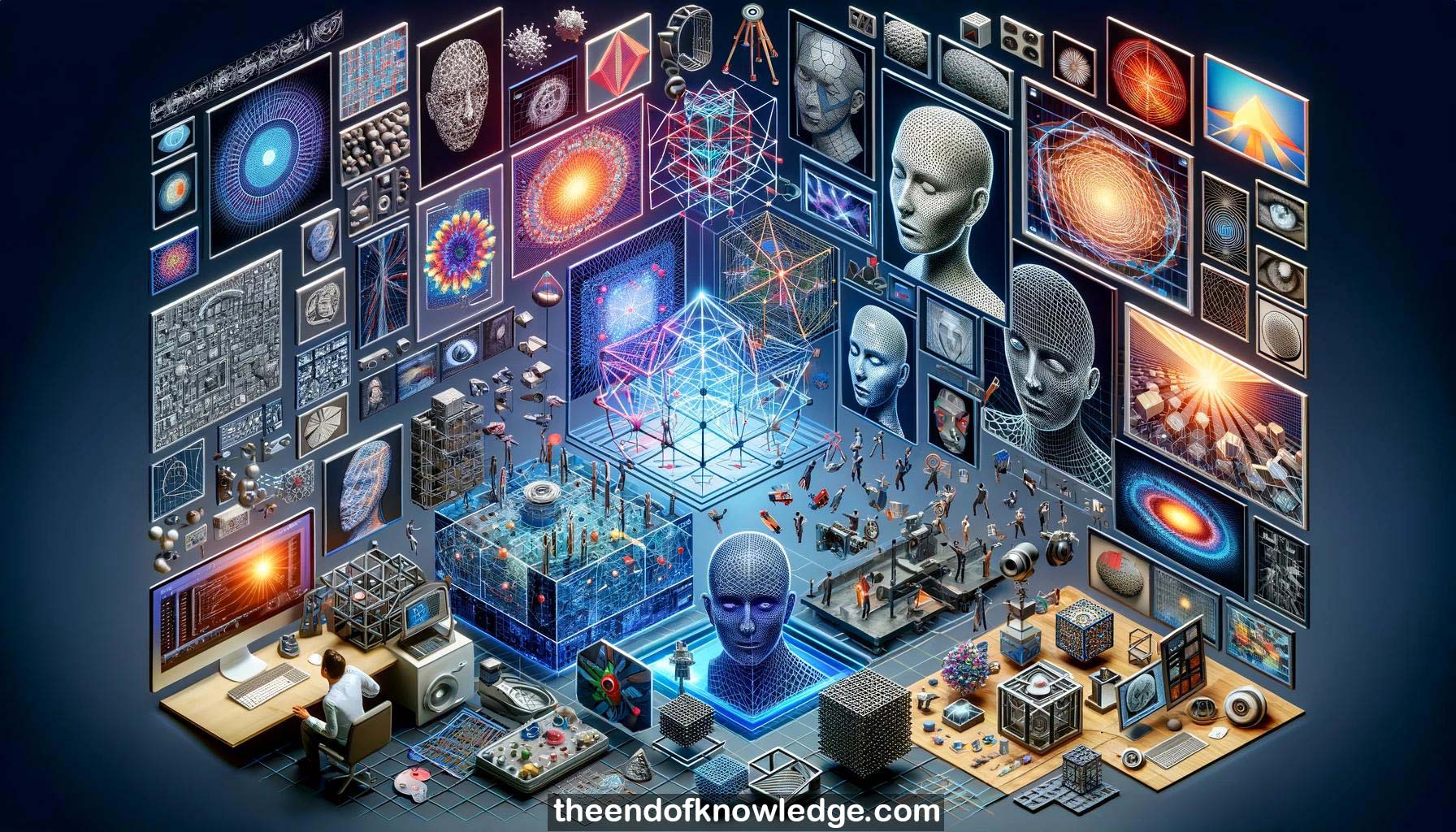

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4 | Gemini Adv | Llama 3:

Resumen:

1.-Lourdes Agapito discute cómo aprender representaciones 3D del mundo solo a partir de imágenes o videos, sin anotaciones 3D.

2.-Estructura desde movimiento y estéreo multivista son ejemplos clásicos de aprendizaje 3D a partir de observaciones 2D, utilizando métodos de optimización geométrica.

3.-Las redes neuronales ahora pueden usarse para inferir representaciones 3D, entrenadas con pérdidas 2D como la consistencia fotométrica entre vistas sintetizadas y reales.

4.-Las representaciones 3D pueden ser vóxeles discretos, nubes de puntos, mallas o funciones implícitas como campos de distancia firmados representados por redes neuronales.

5.-La investigación de Agapito se centra en aprender modelos 3D deformables que capturan cómo varían las formas de los objetos a lo largo del tiempo y entre categorías de objetos.

6.-Los embeddings de bajo rango pueden aprenderse a partir de observaciones 2D para representar eficientemente las deformaciones 3D de objetos como caras, sin datos de escaneo 3D.

7.-Las pérdidas fotométricas que comparan imágenes re-renderizadas con fotogramas de video de entrada permiten aprender modelos detallados de caras 3D deformables para aplicaciones como síntesis de video multilingüe.

8.-Las representaciones de escenas 3D conscientes de objetos combinan la reconstrucción 3D con la detección de objetos 2D para adjuntar etiquetas semánticas a la geometría 3D.

9.-Las representaciones neuronales implícitas como DeepSDF pueden representar formas 3D completas a partir de observaciones parciales aprovechando priors de forma pre-entrenados.

10.-Los campos de radiancia neuronal (NeRF) utilizan redes completamente conectadas para representar escenas 3D y permitir la síntesis de vistas novedosas a partir de un conjunto de imágenes de entrada.

11.-Persisten los retos en el aprendizaje de representaciones 3D que sean útiles para agentes encarnados que interactúan de manera segura con humanos en el mundo real.

12.-Los robots necesitan anticipar acciones humanas e incorporar priors físicos, no solo reconocer la geometría 3D, para asistir a los humanos sin comandos explícitos.

13.-Los modelos 3D generativos deben desentrañar factores como forma, textura, iluminación y deformación para permitir la edición controlada y la síntesis de objetos novedosos.

14.-Técnicas como ConvNeRF permiten la reconstrucción 3D a nivel de categoría a partir de una sola imagen aprendiendo priors de forma y textura de colecciones de imágenes.

15.-La reconstrucción 3D de escenas dinámicas y objetos deformables como el cuerpo humano sigue siendo un reto abierto en comparación con escenas estáticas.

16.-La edición realista de expresiones faciales, emociones y lenguaje corporal en videos de cabezas parlantes sintetizadas es un problema no resuelto.

17.-Escalar la animación facial para trabajar a partir de un pequeño número de fotos en lugar de varios minutos de video de entrenamiento es un área de investigación activa.

18.- Sintetizar escenas dinámicas completas con personas interactuando con objetos es extremadamente desafiante y un problema abierto importante.

19.-Las representaciones de escenas neuronales conscientes del 3D deben extenderse para predecir las posibilidades de los objetos, la semántica y las propiedades físicas, no solo la geometría y la apariencia.

20.-El aprendizaje auto-supervisado de representaciones 3D debería explorar la integración de múltiples modalidades como visión, lenguaje, audio e interacción para reducir los requisitos de anotación.

21.-Las comunidades de visión por computadora, gráficos, robótica y aprendizaje automático deberían colaborar para desarrollar representaciones de escenas 3D útiles para la percepción e interacción.

Knowledge Vault construido porDavid Vivancos 2024