>

>

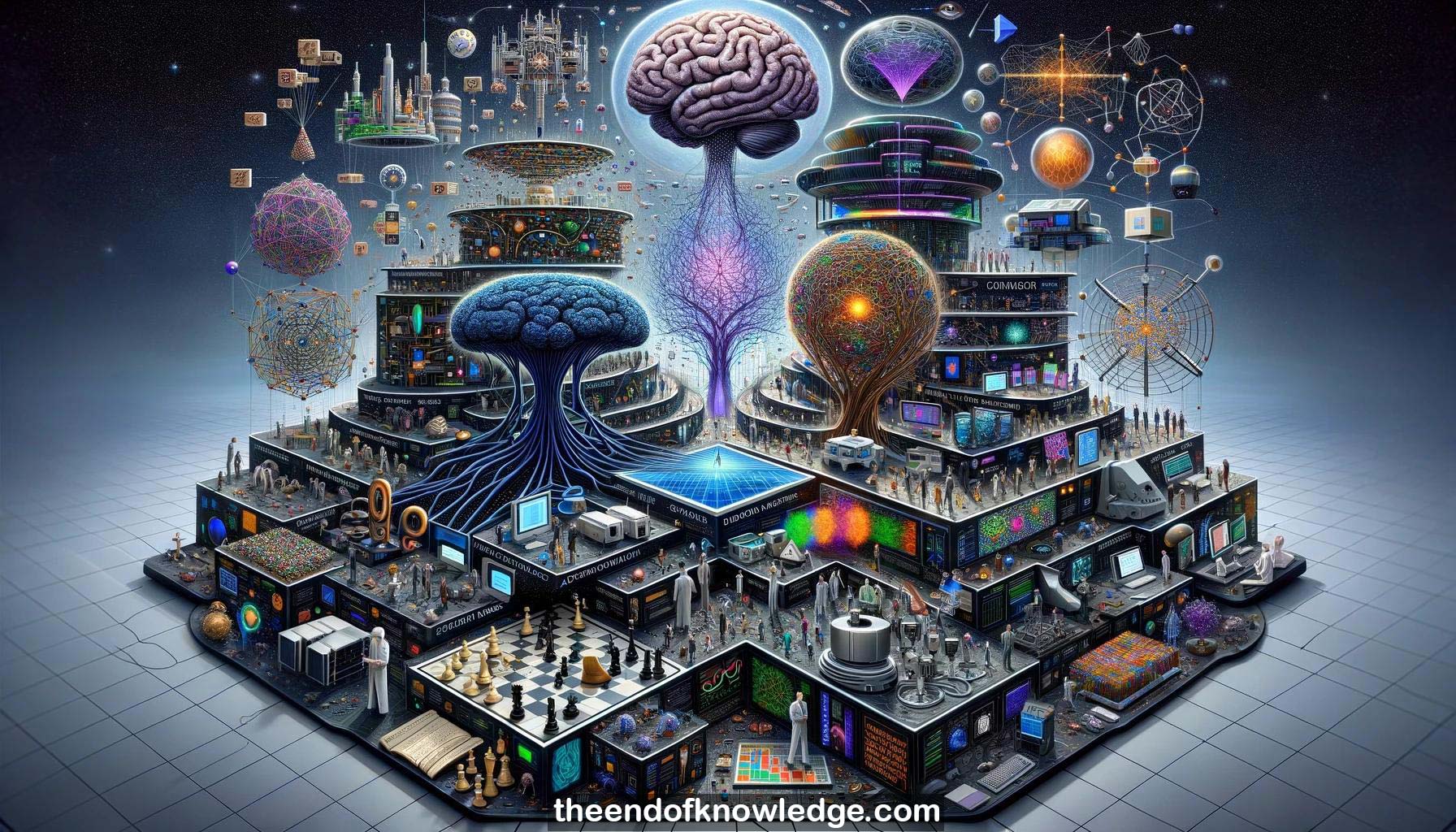

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4 | Gemini Adv | Llama 3:

Resumen:

1.-Chris Manning discute el diseño de redes neuronales para tareas de cognición y razonamiento de nivel superior más allá de la simple respuesta estímulo-intuitiva.

2.-Los éxitos actuales del aprendizaje profundo están en tareas instintivas para los humanos; el razonamiento requiere un pensamiento deliberado cuidadoso.

3.-El razonamiento se define como la manipulación algebraica del conocimiento adquirido para responder nuevas preguntas. Las reglas de composición son centrales.

4.-Manning aboga por el uso de priorizaciones estructurales apropiadas pero flexibles como sesgos inductivos para permitir un aprendizaje efectivo.

5.-Los modelos estructurados en árbol proporcionan un buen sesgo inductivo pero son difíciles de optimizar. La atención ofrece una alternativa.

6.-El objetivo es fomentar el razonamiento composicional de múltiples pasos en redes neuronales manteniendo la diferenciabilidad y escalabilidad.

7.-El conjunto de datos CLEVR prueba la respuesta a preguntas visuales que requieren razonamiento sobre atributos de objetos, relaciones, números.

8.-Los ejemplos de CLEVR incluyen programas funcionales que especifican pasos de razonamiento para responder la pregunta.

9.-Enfoques anteriores de CLEVR usaron fuerte supervisión de programas funcionales o capas especializadas en ConvNets.

10.-Las redes de Memoria, Atención y Composición (MAC) se introducen para el razonamiento de múltiples pasos.

11.-Las redes MAC utilizan una celda MAC recurrente versátil para adaptar el comportamiento a diferentes operaciones de razonamiento.

12.-Las celdas MAC tienen estados de control y memoria separados. El control extrae instrucciones, leer recupera información, escribir actualiza la memoria.

13.-La atención se utiliza extensamente en las redes MAC para mantener la diferenciabilidad mientras se simula un razonamiento complejo.

14.-La pregunta se codifica con un LSTM. La imagen se codifica con un ResNet como base de conocimiento.

15.-La unidad de control atiende a las palabras de la pregunta para calcular una representación de consulta específica del tiempo.

16.-La unidad de lectura relaciona elementos de la base de conocimiento con la memoria y el control previos para recuperar información.

17.-La unidad de escritura puede usar una capa lineal simple o mecanismos más complejos de autopista o autoatención.

18.-Las redes MAC son modelos completamente diferenciables de extremo a extremo para el razonamiento de múltiples pasos.

19.-En CLEVR, las redes MAC logran un 98.9% de precisión, reduciendo a más de la mitad las tasas de error del estado del arte anterior.

20.-Las redes MAC aprenden mucho más rápido que las alternativas, funcionando bien incluso con 1/10 de los datos de entrenamiento.

21.-En el conjunto de datos CLEVR-Humans que prueba la transferencia a preguntas redactadas por humanos, las redes MAC superan a otros enfoques.

22.-Las distribuciones de atención en las redes MAC ayudan a interpretar los pasos de razonamiento que se realizan en la pregunta y la imagen.

23.-Las redes MAC difieren de las redes de módulos neuronales al usar una celda universal en lugar de módulos especializados.

24.-Las redes MAC se benefician de separar el control y la memoria y usar atención en lugar de normalización condicional como en FiLM.

25.-La charla aboga por diseñar arquitecturas neuronales con sesgos inductivos para el razonamiento como un desafío para la comunidad.

26.-Las limitaciones potenciales son que las redes MAC deciden los pasos de razonamiento independientemente de la información recuperada.

27.-Permitir que la memoria influya en el control futuro podría ayudar al razonamiento impulsado por el conocimiento.

28.-Las distribuciones de atención ayudan a la interpretabilidad de los pasos de razonamiento pero aún tienen limitaciones.

29.-Generar explicaciones textuales junto al razonamiento es una posible dirección para mejorar la explicabilidad.

30.-La charla tiene como objetivo impulsar más investigación en bloques de construcción neuronales para inferencia y razonamiento de nivel superior.

Bóveda de Conocimiento construida porDavid Vivancos 2024