>

>

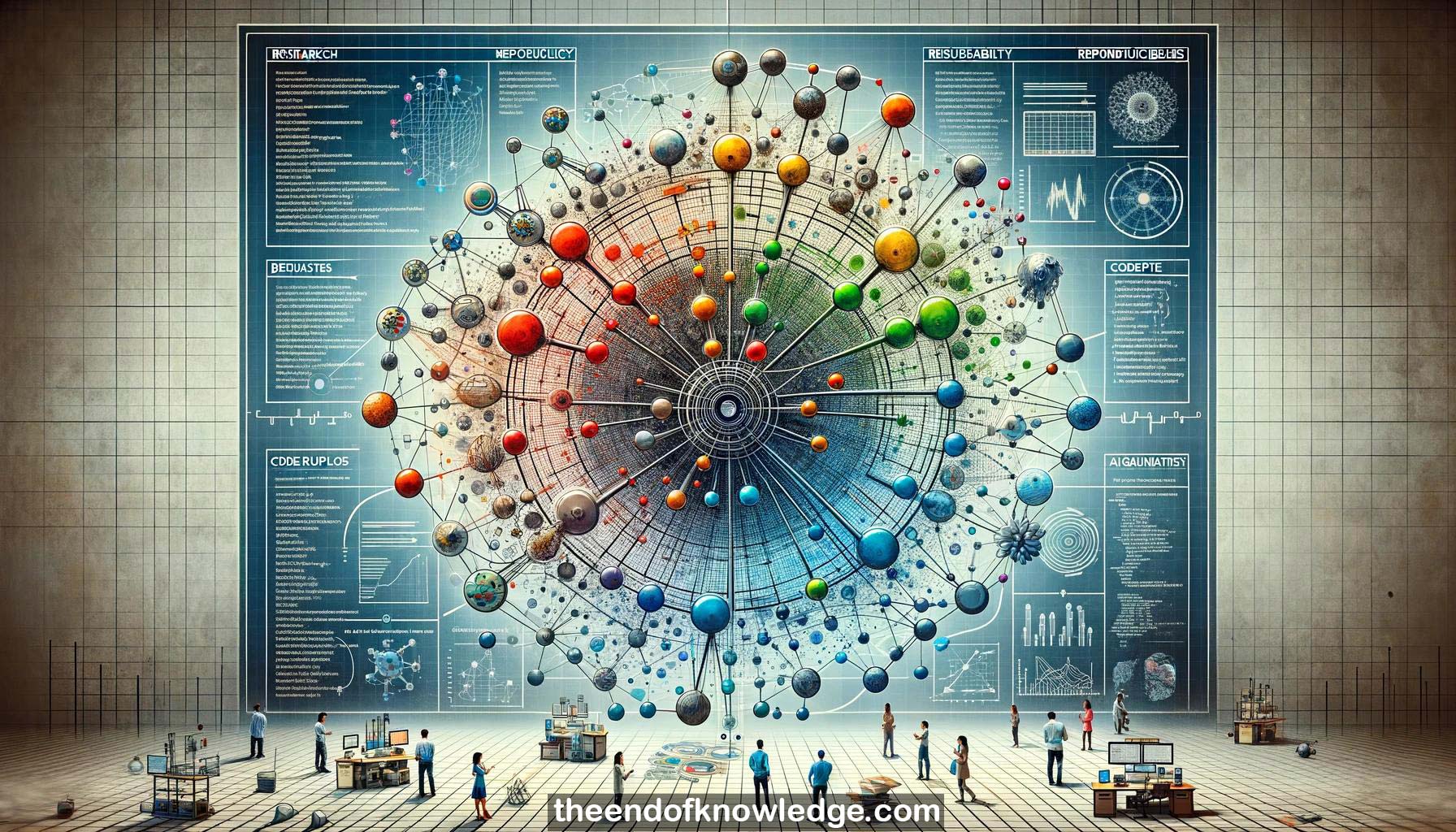

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4 | Gemini Adv | Llama 3:

Resumen:

1.-La Dra. Joelle Pineau da una charla principal sobre reproducibilidad, reusabilidad y robustez en el aprendizaje por refuerzo (RL) en la conferencia ICLR.

2.-Reproducibilidad significa poder duplicar los resultados de un estudio previo usando los mismos materiales que utilizó el investigador original.

3.-Una encuesta de Nature encontró que el 50-80% de los científicos en varios campos han fallado en reproducir los experimentos de otros, indicando una crisis de reproducibilidad.

4.-La verdadera erudición implica compartir el software completo, los datos y las instrucciones para generar resultados, no solo comunicar hallazgos.

5.-La investigación en RL ha explotado de 35 personas en 2000 a 13,000 artículos en 2016, haciendo difícil evaluar las contribuciones.

6.-Los impresionantes resultados de AlphaGo en Go fueron difíciles de replicar para otros equipos debido a la inaccesibilidad de los juegos, el código y los recursos computacionales.

7.-RL está listo para abordar problemas importantes del mundo real pero necesita mejores prácticas en la caracterización y compartición de resultados.

8.-Habilitar la reproducibilidad requiere compartir software reutilizable, conjuntos de datos y plataformas experimentales desarrolladas desde el inicio de los proyectos.

9.-Conjeturas matemáticas como el último teorema de Fermat tardaron siglos en probarse, desperdiciando generaciones de esfuerzo que podrían haber abordado otros problemas.

10.-Algoritmos base de RL como TRPO, PPO y DDPG muestran un rendimiento muy diferente en simuladores similares, complicando las comparaciones.

11.-Múltiples implementaciones de código abierto de los mismos algoritmos de RL producen resultados drásticamente diferentes, incluso en las mismas tareas.

12.-Hiperparámetros como la estructura de la red, la escala de recompensas y la normalización tienen efectos enormes e interactuantes en el rendimiento de los algoritmos de RL.

13.-El número de muestras utilizadas para medir la recompensa esperada de las políticas de RL aprendidas es a menudo muy pequeño en trabajos publicados.

14.-Usar muy pocas muestras para medir el rendimiento de la política de RL introduce un sesgo positivo y subestima la varianza.

15.-Incluso al usar el mismo código e hiperparámetros, los resultados de RL varían significativamente solo al cambiar la semilla aleatoria.

16.-RL puede potencialmente abordar problemas cruciales del mundo real pero necesita mejorar la reproducibilidad para realizar su impacto potencial.

17.-Facebook AI Research lanzó ELF OpenGo, una base de código abierto y modelos para un bot de juego de Go fuerte para habilitar la reproducibilidad.

18.-El Desafío de Reproducibilidad ICLR 2018 involucró a 124 equipos de 10 universidades que intentaron reproducir resultados de 95 artículos de ICLR.

19.-El 70% de los participantes del Desafío de Reproducibilidad creían que había una crisis de reproducibilidad en ML antes del desafío.

20.-Aproximadamente el 55% de los participantes del desafío reprodujeron con éxito algunos resultados, el 33% reprodujo la mayoría, pero encontraron la tarea muy difícil.

21.-Muchos participantes del desafío utilizaron créditos de cómputo en la nube donados para facilitar la reproducción de resultados que requieren recursos significativos.

22.-El 43% de los participantes del desafío se comunicaron con los autores, y la mayoría estaba moderadamente a altamente confiada en sus conclusiones.

23.-Más del 60% de los autores planeaban actualizar sus envíos a ICLR basándose en la retroalimentación del desafío de reproducibilidad.

24.-El 79% de los autores dijeron que se ofrecerían voluntarios para futuros desafíos de reproducibilidad por la valiosa retroalimentación que proporciona.

25.-Los intereses en competencia entre la reproducibilidad científica y la propiedad intelectual comercial pueden ser navegados eligiendo socios receptivos.

26.-Etiquetar prominentemente los artículos reproducibles y establecer incentivos podría alentar a los autores a hacer su trabajo más reproducible.

27.-La reproducibilidad es a menudo parcial y difícil de resumir en binario, por lo que aún requiere leer los detalles proporcionados por los intentos de reproducción.

28.-Cuestionar los propios resultados positivos y negativos y documentar cuidadosamente todos los pasos mejora la reproducibilidad.

29.-Re-ejecutar el código justo antes de enviar el artículo detecta problemas de cambios de código realizados después de generar resultados.

30.-Pineau argumenta que la reproducibilidad requiere rigor y diligencia, sin soluciones mágicas, y debe ser un enfoque clave en ML.

Bóveda de Conocimiento construida porDavid Vivancos 2024