>

>

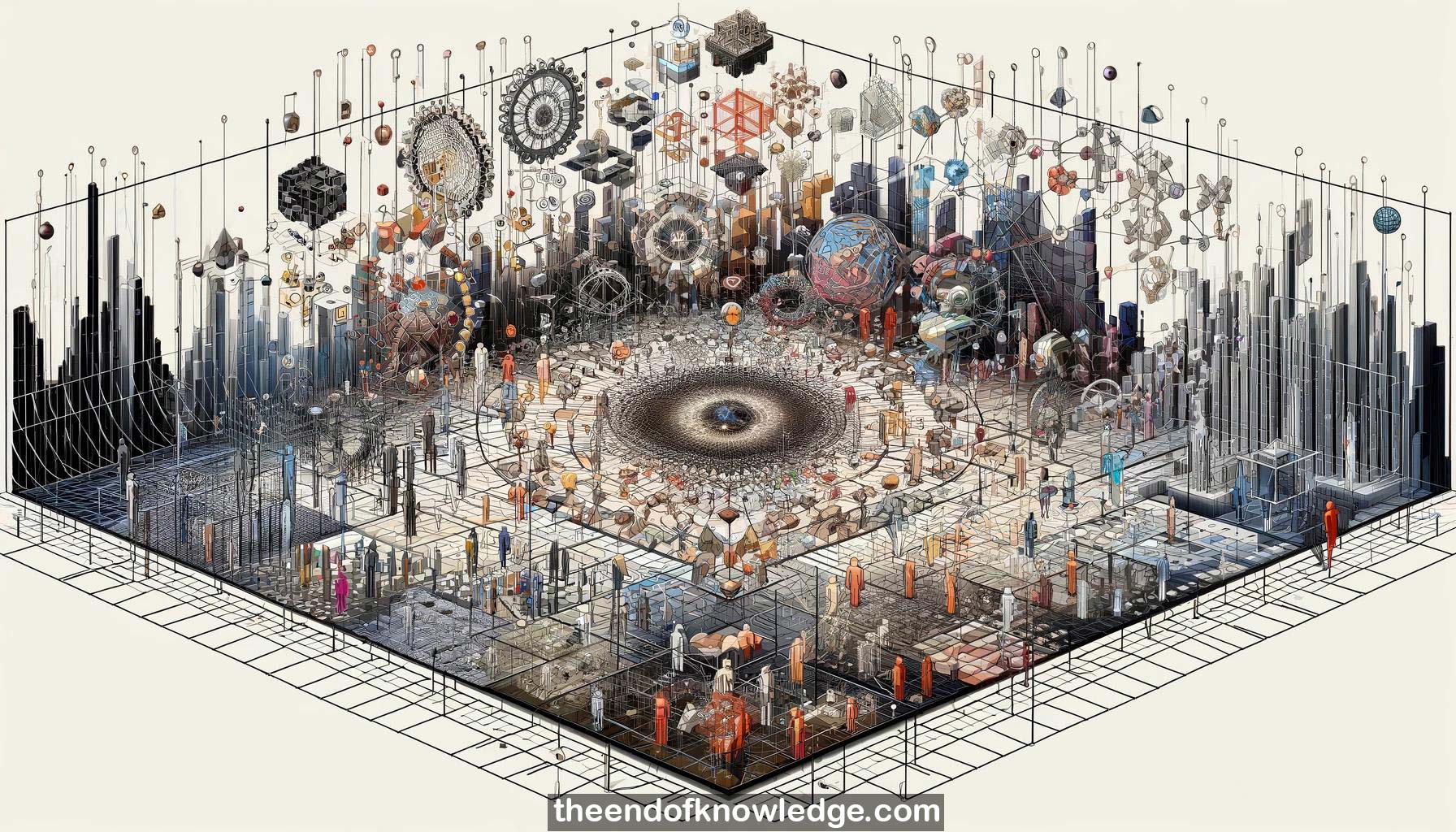

Gráfico de Conceptos & Resumen usando Claude 3 Opus | Chat GPT4 | Gemini Adv | Llama 3:

Resumen:

1.-La charla presenta trabajo en progreso sobre el uso de la teoría de grupos de simetría como base para el aprendizaje automático, especialmente el aprendizaje de representaciones.

2.-En geometría, la simetría de un objeto es una transformación que mapea el objeto a sí mismo. Las simetrías pueden componerse y satisfacer axiomas de grupo.

3.-Los grupos de simetría continua se llaman grupos de Lie. Un ejemplo es el grupo de simetrías del espacio euclidiano, que preserva las distancias entre puntos.

4.-Una simetría de una función es un cambio de entrada que no cambia el resultado. Esta es la noción clave para aprender representaciones.

5.-La simetría es poderosa en matemáticas, física, búsqueda/optimización, seguimiento de modelos en visión, inferencia probabilística elevada, pero hasta ahora infrautilizada en el aprendizaje automático.

6.-Una simetría de un clasificador es un cambio de representación de entrada que preserva la clase. Las variaciones importantes son los objetivos; las no importantes son sus simetrías.

7.-El objetivo es aprender y componer las simetrías de la función objetivo para trivializarla. Esto permite aprender buenas representaciones con menos datos.

8.-Beneficios: reduce la complejidad de la muestra, generaliza algoritmos, conduce a resultados formales, permite el aprendizaje profundo mediante composición, se aplica a través de paradigmas de aprendizaje.

9.-ConvNets son un caso limitado que traduce un mapa de características sobre una imagen. Reemplazar la traslación por grupos de simetría arbitrarios los generaliza significativamente.

10.-El grupo afín de transformaciones lineales de imagen es un siguiente paso natural después de la traslación, incluyendo rotaciones, reflexiones, escalado. Esto da lugar a Redes Afín Profundas.

11.-Una capa de Red Afín Profunda aplica cada transformación afín a la imagen, calcula características en cada una y agrupa sobre vecindarios afines locales.

12.-La viabilidad computacional requiere interpolar características entre las calculadas en puntos de control y usar búsqueda de vecino más cercano. Los árboles de bolas permiten esto eficientemente.

13.-En dígitos MNIST rotados, las Redes Afín Profundas de 1 capa superan ampliamente a las ConvNets de 1 capa con menos datos al manejar rotaciones directamente en lugar de aproximadamente.

14.-Próximos pasos: más capas, distorsiones más ricas, imágenes del mundo real; desarrollar redes de subproducto; combinar con teoría de cápsulas para composición parte-todo.

15.-El análisis semántico mapea oraciones a fórmulas lógicas. Las simetrías (sinónimos, parafraseos, voz activa/pasiva, etc.) preservan el significado de una oración.

16.-Las órbitas de oraciones bajo transformaciones sintácticas corresponden 1-1 con significados, evitando representar explícitamente significados y permitiendo un aprendizaje más fácil de pares de oraciones.

17.-Un analizador semántico encuentra la órbita de oración (significado) más probable. Los nuevos significados crean nuevas órbitas. Esto se puede hacer eficientemente usando la estructura de composición de órbitas.

18.-El aprendizaje descubre las simetrías (analizador semántico) de pares de oraciones. El objetivo es un conjunto generador mínimo para cubrir eficientemente simetrías complejas.

19.-Las reglas de inferencia lógica son simetrías de bases de conocimiento, por lo que el razonamiento también puede encajar en este marco de análisis semántico basado en simetría.

20.-La teoría de grupos de simetría es fundamental para el aprendizaje automático junto con la probabilidad, la lógica, la optimización. Combinarlos desata su potencial, como se muestra en estos ejemplos iniciales.

21.-La falta de datos de parafraseo es un problema, pero los corpus de traducción automática podrían ayudar. El aprendizaje de simetría también se aplica naturalmente a las conexiones visión-lenguaje.

22.-El álgebra de simetría es general, no requiere simetrías perfectas en el dominio. Se relaciona con trabajos recientes que comparan redes profundas vs poco profundas.

23.-Las simetrías fuertes hacen que los puntos de datos sean equivalentes, abstraen permanentemente la información distintiva, lo que a menudo es deseable para separar claramente las clases objetivo.

24.-Los problemas del mundo real a menudo requieren invariancia "difusa", preservando la discriminación para la tarea final. Esto se puede manejar a través de órbitas probabilísticas o optimización de discriminación.

25.-En resumen, la teoría de grupos de simetría proporciona una base poderosa para el aprendizaje de representaciones y se extiende naturalmente a muchas áreas, con un potencial rico.

Vault de Conocimiento construido porDavid Vivancos 2024